第3回 AI導入に失敗しないために知っておきたいこと

前回のコラムでは、AI導入にあたって知っておきたいポイントについて説明しました。今回はAI導入に失敗しないために知っておきたいことについてお話します。

1. AI導入を阻害する要因

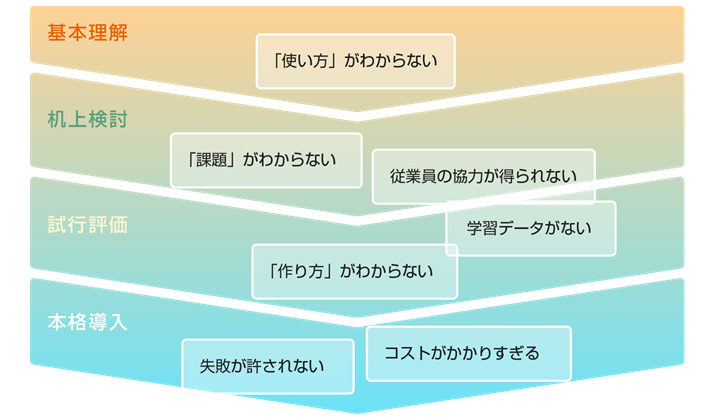

以下の図はAI導入を阻む7つの要因をまとめたものです。

AI導入を阻む要因

7つの要因のなかで前回のコラムで触れていなかったのは「従業員の協力が得られない」という要因です。従業員は、AIにより自分の仕事のやり方が変えられてしまったり、無くなってしまったりするのでは、という危機感を抱くため、AI導入に対して非協力的になる傾向があります。その結果、業務のどの部分にノウハウが必要なのか、どんな情報を業務判断に使っているか、業務の各プロセスの所要時間や発生件数がどのくらいなのかなど、AIの作成や導入効果の算定に必要な情報を十分説明してもらえないリスクがあります。そのようなトラブルを避けるためには、AI導入がAIを利用する従業員にとってもメリットがあることを理解してもらう必要があります。たとえば、繁忙期には処理しきれない案件が溜まってしまい、残業が続くような仕事の一部をAIが担当することで定時に帰れるようになったり、人間ではどうしても避けることのできない仕事のポカミスをAIにチェックしてもらうことで、ストレスがたまるアフターフォローの作業をしなくて済むようになるのは従業員にとってうれしいことです。

2. 「人間の能力を強化する」というAIの使い方

このような従業員をサポートするAIの使い方はAIをArtificial Intelligence(人工知能)ではなく、Augmented Intelligence(拡張知能)ととらえる使い方といえます。ここ数年のAIブームの中で、AIに対する理解が進み、人間の仕事を完全にAIに置き換えることは現時点では難しいので、部分的に仕事をAIにやらせることで、人間の仕事をサポートして生産性を向上させようという動きが増えてきました。では具体的には、AIによるサポートとはどのようなものなのでしょうか?

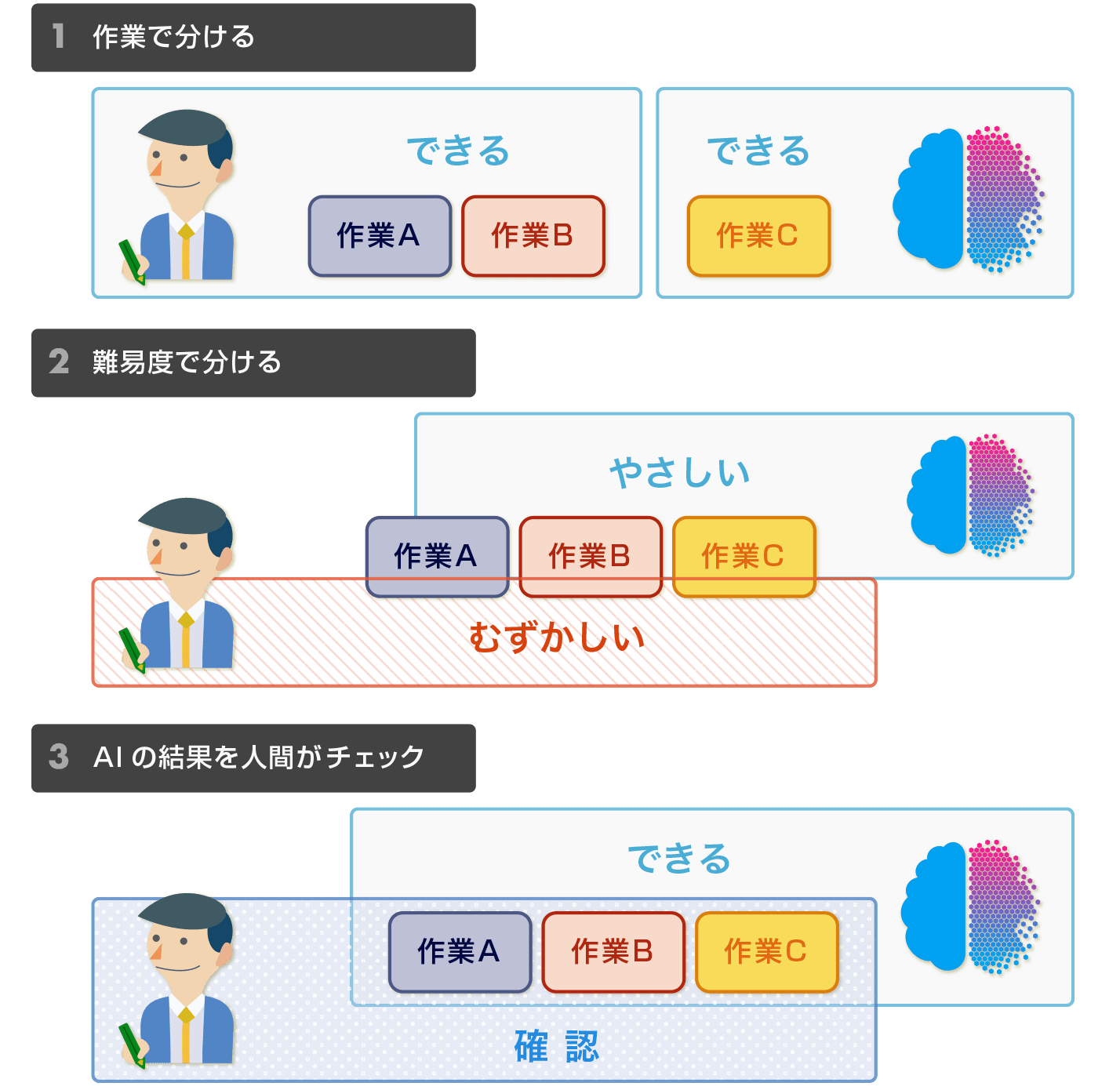

人間とAIの組み合わせ方

AIによる人間のサポートには下の図のように大きく3種類の形態があります。もっとも一般的なのは、複数の作業をAIができるものと人間しかできないものに分けて行うというやり方です。たとえば申込書の処理でいえば、記載内容の電子化や記載漏れのチェックなどをAIが担当し、申し込みの可否判断は人間が行うという使い方です。

もうひとつのやり方は、同一の作業を案件の難易度に応じて分け、簡単なものをAIが難しいものを人間が担当するやり方です。このやり方は保険の審査業務などで採用されており、案件の難易度にばらつきがある場合に有効です。

3つめのやり方はAIが作業を行い、人間がAIの作業結果をチェックし修正を行なうというやり方です。銀行の融資や法務部門の契約書の審査など、慎重を期す必要のある作業にこのやり方が採用されています。

3種類の人間とAIの分業パターン

3. 従来のITシステムとの違い

もう1つ導入にあたって注意しなければいけないことは、AIを導入したシステムと従来のITシステムには大きな違いがあるということです。この違いを意識しないと、思いもしないトラブルに巻き込まれる恐れがあります。

前回のコラムでは、AIの導入のプロセスにおいて試行的にAIを適用するPoC(Proof of Concept)フェーズの導入が特色であると説明しましたが、その他以下の表のように4つの大きな違いがあります。

| 従来のシステム | AIシステム | |

|---|---|---|

| 開発手法 | ウォーターフォール 上流から下流へ一方通行 |

アジャイル 短い繰り返し型 |

| 判断ロジック | 説明書に記述しプログラム化 | 設計書に記述されない学習結果として記録 |

| 実現する精度 | 100% | 100%でない |

| 品質評価 | テストデータに対して間違いがないこと | テストデータに対して目標精度を上回ること |

作り方の違い

設計段階では、従来は処理手順を設計書に書きだす必要がありましたが、AIが処理を担当する部分については、処理がブラックボックスとなってしまうため、設計書にその手順を書くことができません。また、AIを使う場合、PoCフェーズにおいて試行錯誤を繰り返しながらプロトタイプを作成していくことから、短期間に開発サイクルを回すことを繰り返すアジャイル型と呼ばれる開発手法が良く用いられます。

間違いや出力の変化が発生する

従来と違って、AIを使ったシステムは100%の精度を保証できないため、システムの目標精度はPoCの結果などから決める必要があります。また、AIが誤りを起こした場合、正しい結果を返すように修正することは従来のシステムでは比較的容易でしたが、AIを使う場合、学習結果がブラックボックスとなっているためその修正は容易ではありません。また、AIは学習するにつれて入力に対する出力が変化するため、従来は必須であった入力に対する出力の同一性を保証できません。

AIの誤動作への対策

AIサービスを開発する人間はサービスが深刻な問題を引き起こす可能性に注意する必要があります。たとえばAIが誤動作して人命を脅かしたり経済的被害を与えたりしないためにはどうすればいいでしょうか?そのためには通常のITシステムではフェイルセイフとよばれるシステムの制御の仕組みを組み込んで対処しています。AIは、同じ入力でも学習によって出力が変化すること、未知の入力に対する出力が予期できないことから、誤作動に対する入念な対策が必要です。

偏ったデータによる学習の危険性

理性的で公平な判断を期待されるAIが、差別的な発言や偏見に満ちた判断をする可能性にも注意が必要です。これは差別的な記述を含むテキストや、偏見に基づいた判断結果を学習データとしてAIが作成されることにより起こります。たとえば、ユダヤ人を差別する発言を聞かされたマイクロソフトのAIがヒトラーを賛美するようになった事件や、犯罪者の画像データを学習させたアマゾンのAIが米国の上院、下院議員のうち高い割合で黒人の議員を犯罪者と誤認識した事件がこの問題にあたります。

| AIによるサービス | AIが起こした問題 |

|---|---|

| 顔画像認識 | 黒人の顔が犯罪者と誤認識されやすい |

| 人材採用 | 女性が採用されにくい |

| まばたき検知 | 東洋人の笑顔がまばたきと判断されてしまう |

| 機械翻訳 | 女性を指す単語を男性代名詞にしてしまう |

| チャットボット | 人種差別、ヒットラー賛美の発言をしてしまう |

| 画像検索 | 「黒人の若者」で検索すると逮捕者の顔写真が多くヒットする |

| 写真分類 | 黒人をゴリラに分類 |

| 再犯予測 | 黒人の再犯リスクを高く推定してしまう |

参考情報

本コラムの著者の新しい本が出版されました!

ビジュアル AI(人工知能) 城塚 音也 著

Writer Profile

Blue3事業部

戦略推進担当 プリンシパル

城塚 音也

Tweet