はじめに

ここ数年、生成AI(Generative AI)の技術は急速に普及し、様々な企業で導入が進められています。生成AIは、テキスト生成、画像生成、音声合成など、多岐にわたる分野でその成果が報じられています。

総務省「情報通信白書 令和7年版」によると、日本企業では約50%が生成AIを活用する方針であり、米国の約85%と比べるとまだ低いものの、近いうちに同レベルに追いつくものと推測されます。

また、株式会社 ICT総研「2025年7月 法人向け生成AIサービス利用動向調査に関する調査」によると、実際に多くのユーザーに使用されている生成AIサービスとしては、ChatGPT、Microsoft Copilot、Gemini、Claudeなどが代表的であり、それぞれの利用率は以下の通りです。

- •ChatGPT:利用率52.1%

- •Microsoft Copilot:利用率42.3%

- •Google Gemini:利用率28.5%

- •Claude:利用率13.1%

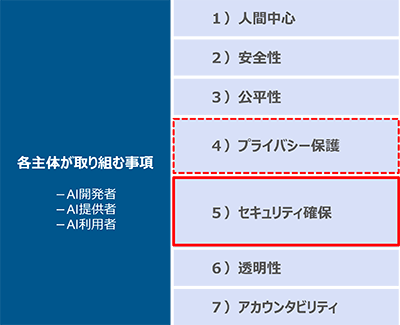

しかし、その一方で、生成AIの技術は進化の途上にあり、新たなリスクの発生が懸念されています。総務省「AI 事業者ガイドライン(第1.1版)」では、AIシステム・サービスの開発・提供・利用のため、7つの共通指針について各主体(AI開発者、AI提供者、AI利用者)が主体的に取り組む重要テーマと位置づけています。

図1:各主体(AI開発者、AI提供者、AI利用者)が主体的に取り組む重要テーマと本コラムのスコープ

本コラムでは、これら7つのテーマのうち、「セキュリティ確保」および一部「プライバシー保護」に焦点を当て、AI、とくにLLM(大規模言語モデル)による生成AIを中心に現状クローズアップされている脅威とその対策について解説します。

1. 生成AIのシステムの仕組み

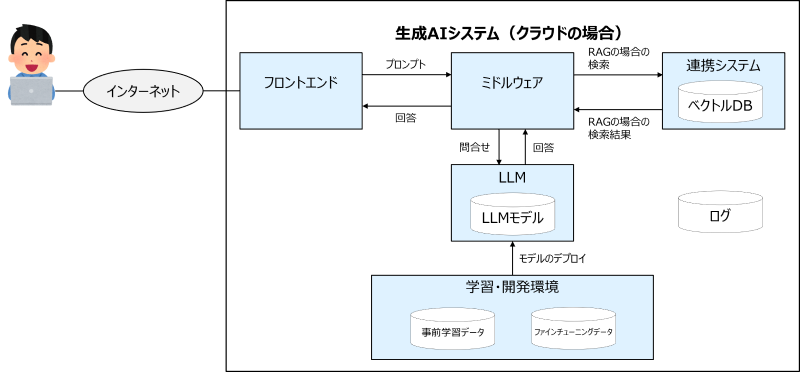

一般的なLLMのシステム環境は、以下の通りとなります。生成AIシステムの仕組みを単純化すると、LLM、学習・開発環境、ミドルウェア、フロントエンド、連携システムといったコンポーネントで構成されています。また、これらの仕組みを乗せるためのIT基盤も存在します。

図2:一般的な生成AIシステムの構成イメージ

なお、いくつかの用語について、その定義を以下に記載します(わかりやすさを優先した定義としています。専門的な定義ではありませんのでご注意ください)。

- •モデル(Model)とは:入力データに基づいて、最適な出力を生成するための構造や仕組みの総称のこと。

- •LLM(Large Language Model)とは:大規模言語モデルとも呼ばれる。大量のテキストデータを事前学習して、人間のように自然な言語を理解・生成できるAIのモデルのこと。

- •ファインチューニング(fine-tuning)とは:すでに学習済みのAIモデル(例えばLLM)に対して、特定の目的やデータに合わせて追加学習を行うこと。

- •RAG(Retrieval-Augmented Generation)とは:検索拡張生成とも呼ばれる。AIが回答を生成する際に、外部の情報を検索して取り込むことで、より精度の高い応答を行う技術のこと。

- •ベクトルDBとは:特にRAG構成でAIを使う場合に必要となる要素。文章や画像などの情報(非構造化データ)をベクトル(数値データのかたまり)として保存・検索できるデータベースのこと。

これら生成AIの各コンポーネントは、いずれも価値ある情報資産といえます。生成AIのセキュリティというと、一般的には入力データや出力データの機密情報をイメージしがちですが、実はこのようなコンポーネントそれぞれが攻撃者のターゲットにされる可能性があります。

2. 生成AIのセキュリティ脅威

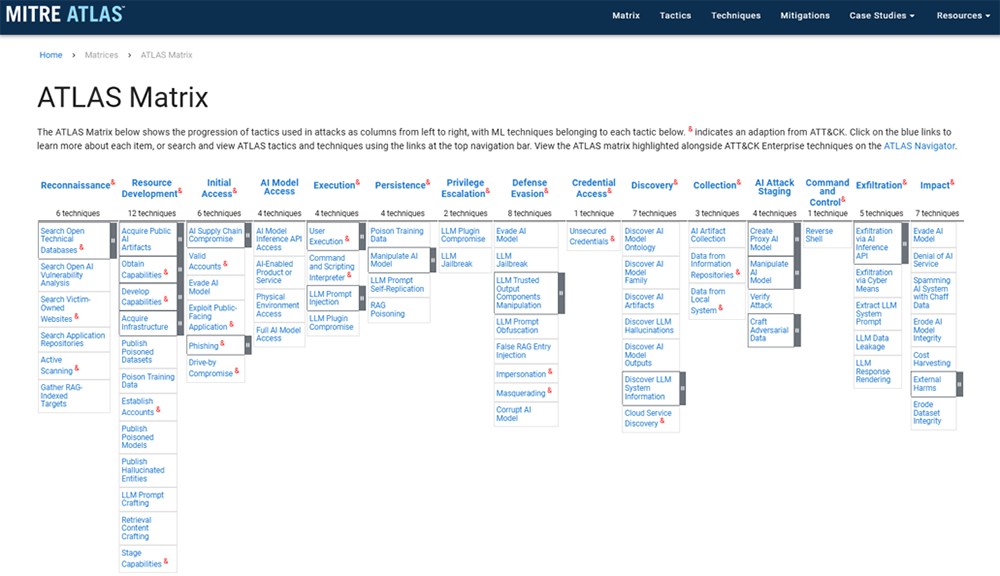

とはいえ、生成AIに対するセキュリティ脅威は、現状において大規模な事故事例が少なくイメージしづらいのが現状です。そこで、MITRE ATT&CKで有名なMITREが公開しているMITRE ATLAS(マイタ アトラス)を参考に、どのような脅威があるのかを見ていきます。

1)MITRE ATLASとは

MITRE ATLASとは、“MITRE Adversarial Threat Landscape for AI Systems”の略です。MITRE ATLASの中で公開されているATLAS Matrixは、AIのセキュリティ脅威のナレッジベースで、2021年に初めて公開されました。公開後は年2,3回ほどアップデートが行われており、2025年8月現在ではv4.9.1が最新版となっています。

ATLAS Matrixは、MITRE ATT&CKがベースとなっており、MITRE ATT&CKと同様の構造で、サイバー攻撃を戦術(Tactics)および、その下位のテクニック(Techniques)によって構成・表現しています。また、テクニックに対する緩和策(Mitigations)も収録されており、関連データや機能の充実性はMITRE ATT&CKほどではないものの、ほぼ同じ感覚で活用できます。

図3:MITRE ATLASのATLAS Matrix

なお、ATLAS Matrixの使用にあたっては、MITRE ATT&CKと同様に以下の注意が必要です。

- •世の中のすべての攻撃手法が収録されているわけではない。

- •必ずしも単一的に攻撃が左から右への順序で行われるわけではない。戻ることや反復することもある。

- •すべての攻撃が実行されるわけではない。同じ攻撃を何度も使用することがある。

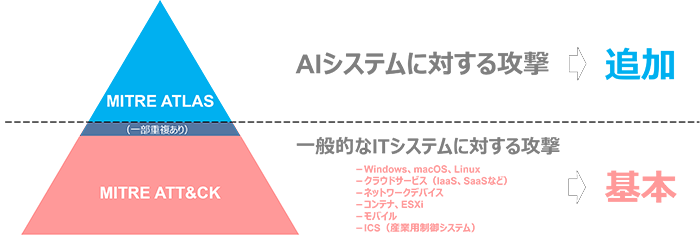

また、ATLAS Matrixは、AIシステムに関する攻撃を対象としていますが、そのAIシステムを搭載するIT基盤への攻撃は対象外となることにも注意が必要です。

図4:MITRE ATLASおよびMITRE ATT&CKのスコープ

2)MITRE ATLASの戦術(Tactics)

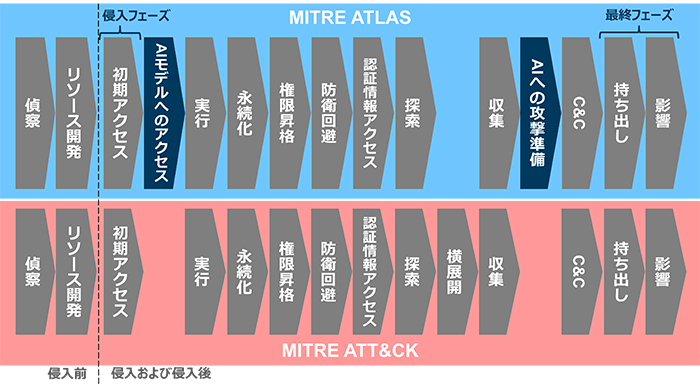

MITRE ATLASの戦術(Tactics)は、多くがMITRE ATT&CKと同じものです。本コラムでは、最初に侵入を行う「初期アクセス」(Initial Access)を侵入フェーズ、攻撃者が最終目標とする「持ち出し」(Exfiltration)および「影響」(Impact)を最終フェーズとしますが、これはMITRE ATT&CKでも同様に存在します。

しかし、侵入フェーズの次にあたる「AIモデルへのアクセス」(AI Model Access)および最終フェーズの前段階にあたる「AIへの攻撃準備」(AI Attack Staging)は、MITRE ATLAS特有の戦術です。

なお、すべての戦術の下位には、合計54ものMITRE ATLAS特有のテクニック(Techniques)が存在しています(サブテクニックは除く)。

図5:MITRE ATLASおよびMITRE ATT&CKの戦術(Tactics)

「AIモデルへのアクセス」は、AIモデルそのものに対する操作や情報取得を試みる戦術です。標的のAIモデルへの何らかのアクセス権を取得することを目的としており、次の実行(Execution)フェーズでデータ窃取や不正データ投入などをするための足掛かりとなります。下位のテクニックには、「AI モデル推論 API アクセス」(AI Model Inference API Access)、「物理環境へのアクセス」(Physical Environment Access)、「AIモデルのフルアクセス」(Full AI Model Access)、「AI対応の製品またはサービス」(AI-Enabled Product or Service)の4つがあります。

「AIへの攻撃準備」は、AIモデルの汚染(ポイズニング)や、攻撃用データの作成を行う戦術です。攻撃の最終フェーズの前段階で、攻撃を行うための環境構築や準備作業を行います。下位のテクニックには、「プロキシAIモデルの作成」(Create Proxy AI Model)、「AIモデルの操作」(Manipulate AI Model)、「攻撃の検証」(Verify Attack)、「敵対的データの作成」(Craft Adversarial Data)の4つがあります。

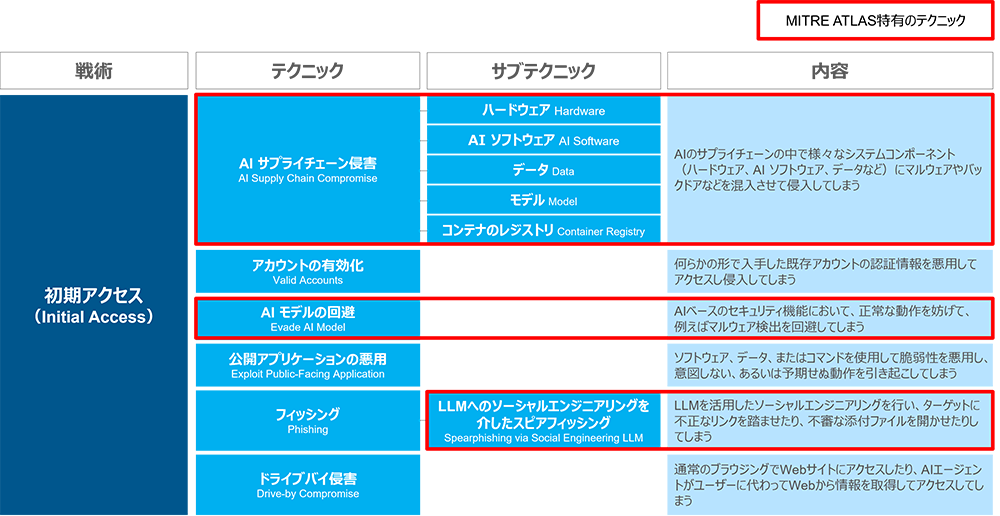

3)侵入フェーズ(初期アクセス)

最初の侵入フェーズである「初期アクセス」(Initial Access)を見てみましょう。複数のテクニックがMITRE ATT&CKにも存在しますが、「AIサプライチェーン侵害」(AI Supply Chain Compromise)および「AIモデルの回避」(Evade AI Model)の2つはMITRE ATLAS特有のテクニックです。また、フィッシングのサブテクニック「LLMへのソーシャルエンジニアリングを介したスピアフィッシング」(Spearphishing via Social Engineering LLM)も特有のサブテクニックです。

図6:初期アクセスのテクニック

AIサプライチェーン侵害は、サプライチェーンリスクがAIシステムにも適用されるパターンです。AIモデルの回避は、AIをセキュリティ機能に利用している場合、攻撃者がマルウェアのコードを改変してその検知を回避できるようにしてしまうケースが考えられます。LLMへのソーシャルエンジニアリングを介したスピアフィッシングは、いわゆる標的型攻撃に近いもので、攻撃者がLLMを使用してさらに精度高く標的を狙い定めて攻撃を実施するものと考えられます。

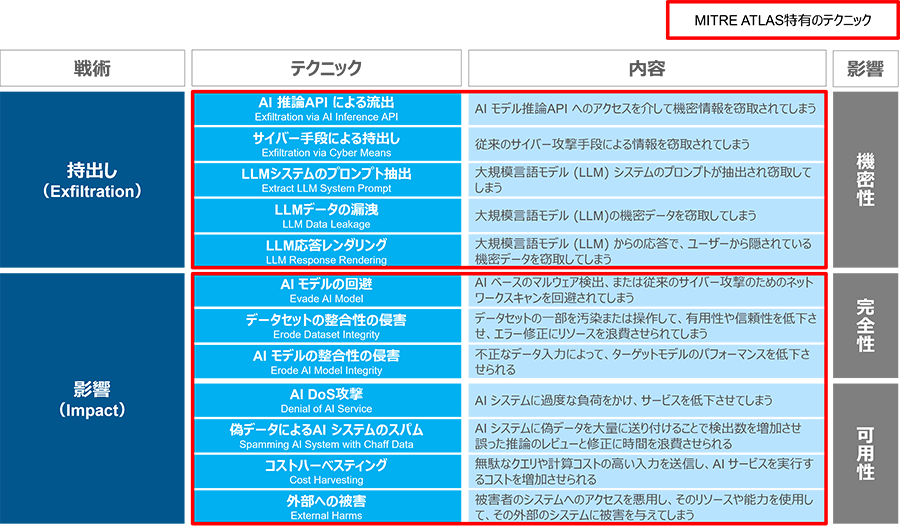

4)最終フェーズ(持ち出し、影響)

次に最終フェーズにあたる「持ち出し」(Exfiltration)および「影響」(Impact)の2つの戦術を見てみましょう。ここではAIへのサイバー攻撃は何を目的に行われるのか、セキュリティ被害は何かを確認してみます。

持ち出しの下位のテクニックからは、機密情報、プロンプト、LLMデータ等の機密性が損なわれる被害が発生します。また、影響の下位のテクニックからは、モデルやデータセット等の完全性や、AIシステムや外部のシステムへの可用性が損なわれる被害が発生します。

図7:持出しおよび影響のテクニック

なお、MITRE ATT&CKではランサムウェア暗号化は「影響」の中のテクニック「Data Encrypted for Impact」として収録されています。AI特有の攻撃ではないためMITRE ATLASには収録されていませんが、ランサムウェア暗号化が行われてしまった場合、結果的にAIシステムにも被害が及ぶ可能性があります。

3. OWASP Top 10とMITRE ATLASの関係

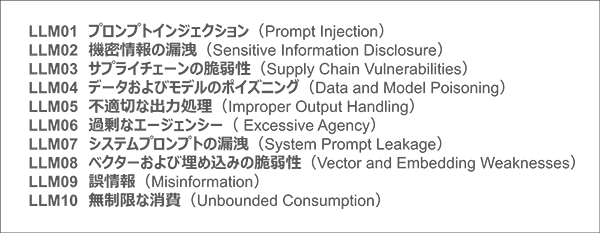

OWASPが公開している「OWASP Top 10 For LLM Applications 2025」(2024年11月)では、特に注意すべきAI、特にLLMに対する10の攻撃が示されています。

図8:OWASP Top 10 For LLM Applications 2025

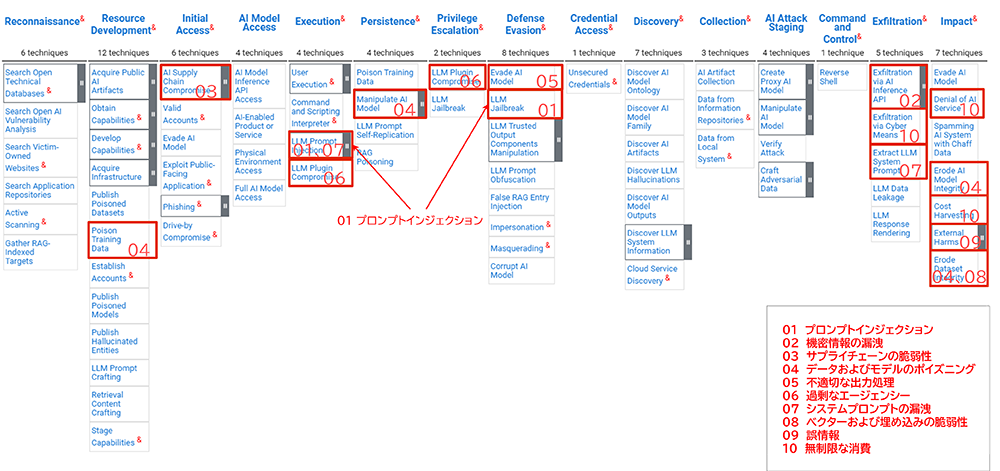

OWASP Top 10 For LLM Applications 2025(以下、OWASP Top 10)では、代表的な攻撃手法が優先度順に記載されているのに対し、MITRE ATLASは、攻撃手法を体系的・網羅的に示しています。もちろん、OWASP Top 10の攻撃のほとんどは、MITRE ATLASにも収録されており、関連する攻撃も含めた対応付けは以下の通りとなります。

図9:MITRE ATLASへのOWASP Top 10のマッピング

(文書「OWASP Top 10 For LLM Applications 2025」内の記載を参考にマッピング)

比較的有名な攻撃であるプロンプトインジェクション(Prompt Injection)は、MITRE ATLASでは「LLM Prompt Injection」および「LLM Jailbreak」として示されており、侵入後の戦術である実行(Execution)、権限昇格(Privilege Escalation)、防衛回避(Defense Evasion)のテクニックと位置づけられています。

なお、OWASP Top 10の攻撃の半分くらいは、最終フェーズにあたる持ち出し(Exfiltration)および影響(Impact)に位置しています。OWASP Top 10は、その選出に攻撃の発生頻度や悪用のしやすさ、影響度合いなどを基準にしていますが、結果的に最終フェーズに集中したものと思われます。

MITRE ATLASに見られるように、AIに対する攻撃手法は非常に多く、これらに対応するには多くのコストと時間を要します。そのため、セキュリティ脅威の優先度付けを行うための基準として、OWASP Top 10は非常に有効です。

まとめ

MITRE ATLASのATLAS Matrixを中心に生成AIのセキュリティ脅威について解説しました。次回は、これらセキュリティ脅威からのリスクを最小化するためのセキュリティ対策の考え方について解説します。

参考資料

- [1]MITRE ATLAS The MITRE Corporation

- [2]MITRE ATT&CK The MITRE Corporation

- [3]OWASP Top 10 For LLM Applications 2025 OWASP Foundation

- [4]AIシステムに対する既知の攻撃と影響 AIセーフティ・インスティテュート (AISI)

- [5]AI 事業者ガイドライン(第1.1版) 総務省・経済産業省

- [6]情報通信白書 令和7年版 総務省

- [7]2025年7月 法人向け生成AIサービス利用動向調査に関する調査 株式会社ICT総研

- [8]テキスト生成AI の導入・運用ガイドライン IPA産業サイバーセキュリティセンター中核人材育成プログラム 7 期生

- [9]SAFE-AI A Framework for Securing AI-Enabled Systems The MITRE Corporation

- ※文中の商品名、会社名、団体名は、一般に各社の商標または登録商標です。