はじめに

第1回では生成AIのセキュリティ脅威について解説しましたが、各企業における生成AIの利用形態はさまざまです。Google等、従来の検索サービスを使用するのと変わらない感覚で無償の生成AIサービスを利用するパターンもあれば、自社ビジネスに特化した独自の生成AIを構築・活用するパターンもあります。

これらの生成AI利用形態の違いは、セキュリティへの取り組みアプローチの違いにもつながります。それでは、どのように整理すればよいのでしょうか。本コラムではこういった観点を交えて生成AIのセキュリティについて主に技術的対策に焦点を当て解説します。

1. AI共有責任モデルとユーザーの立場

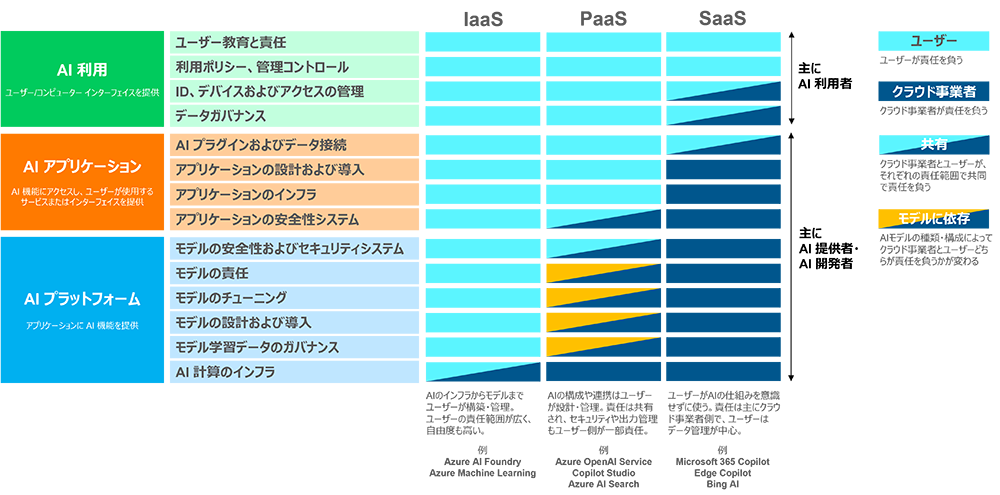

ここで参考になるのが、Microsoft社が公開しているAI共有責任モデル(AI shared responsibility model)です。本モデルは、AIをクラウドサービスで使用する場合のIaaS、PaaS、SaaSそれぞれのケースでユーザーおよびクラウド事業者(この場合、Microsoft社)の責任範囲を示したものです。AI共有責任モデルは、セキュリティだけでなくAI全体に関する責任範囲を示しているため、基本的な責任分界を理解したうえでセキュリティ対策を考えるのに有用です。

図1:AI共有責任モデルとユーザーの立場

(ソリューション例は筆者記載)

総務省「AI 事業者ガイドライン(第1.1版)」では、AIシステム・サービスの開発・提供・利用を行う主体としてAI開発者・AI提供者・AI利用者の3つを定義しています。このうち、AI開発者・AI提供者は、Microsoft社のようなクラウド事業者のことのみを指すと一見思われがちですが、IaaS、PaaSの利用においては、ユーザー企業もAI開発者、AI提供者になりえます。なお、本ガイドラインでは、AI開発者は「AIシステムを開発/研究する事業者」、AI提供者は「AIシステムをアプリケーション、製品、既存のシステム、ビジネスプロセス等に組み込んだサービスとして提供する事業者」、AI利用者は「事業活動においてAIシステムまたはAIサービスを利⽤する事業者」と定義しています。

通常、AI利用者は、生成AIサービスをシンプルにSaaSで利用する立場で、多くの企業がここに位置づけられるのではないでしょうか。AI開発者・AI提供者は、生成AIサービスを何らかの形で改良・カスタマイズするために主にIaaSやPaaSで利用する立場です。そのため、ITベンダーだけではなく、社内の情報システム部門やDX部門、事業部門が該当するという企業も多いと考えられます。

2. AI利用者向け生成AIセキュリティ対策

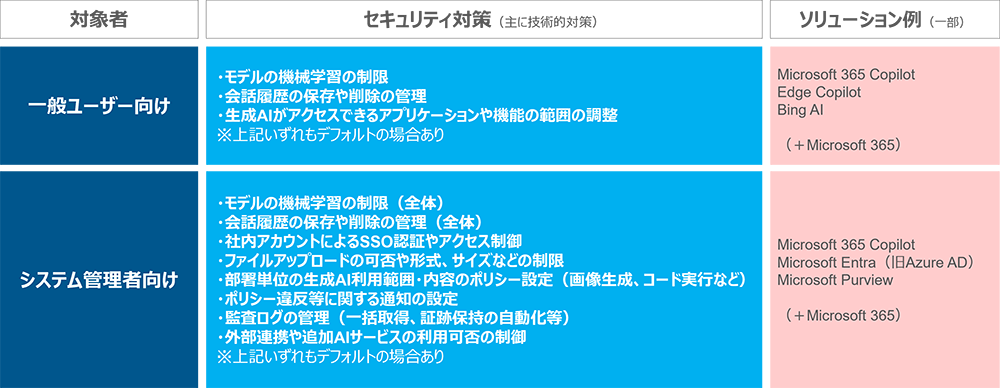

ここでは、AI利用者は、無償もしくは有償のエンタープライズ向けライセンスを購入し利用します。わかりやすい例では、Microsoft 365 CopilotやEdge Copilotを利用するパターンです。AI利用者の生成AIセキュリティ対策においては、一般ユーザー向けとシステム管理者向けの対策とでは立場上、対応すべき事項が異なります。

一般ユーザーについては、生成AIサービスが具備しているデフォルト機能をフル活用してセキュリティを高めることが基本となります。生成AIサービスの設定画面やプライバシーポリシー経由で操作可能なメニューにたどり着くケースがほとんどです。補足となりますが、組織的対策・人的対策としては、社内のセキュリティルールやAI利用ルールを順守することや、機密情報(個人情報を含む)を入力しない、匿名化したデータを入力する、などの対策が考えられます。

システム管理者については、生成AIサービスの契約プランにもよりますが、多くの場合はシステム管理機能が提供されます。生成AIサービスには、ログ監査や認証、利用ポリシー、入出力制限などのセキュリティに関連する機能が提供されるケースが増えており、これらを組織全体の観点において活用することが望まれます。

図2:AI利用者向けセキュリティ対策

なお、生成AIサービスが公開しているプライバシーポリシーには、モデルへの機械学習の可否、ユーザーによる設定変更の可否、保存期間や削除ポリシーなどが書かれています。各社のプライバシーやセキュリティに対する姿勢や考え方を把握するために一読することを推奨します。

3. AI開発者・AI提供者向け生成AIセキュリティ対策

ここでは、AI開発者・AI提供者は、独自モデルの開発や、ファインチューニングなどを行う場合を想定します。わかりやすい例では、Azure OpenAI ServiceやAzure AI Foundryを利用するパターンです。

AI開発者・AI提供者向けの生成AIセキュリティ対策については、第1回と同様に、MITRE ATLASをベースとします。MITRE ATLASでは、AIへのセキュリティ脅威に対して26の緩和策が収録されています(2025年9月現在ではv4.9.1が最新)。これらの緩和策は、「Technical - ML」、「Technical - Cyber」、「Policy」の3つのカテゴリに分類されています。どのような内容なのか、カテゴリ別に見ていきましょう。

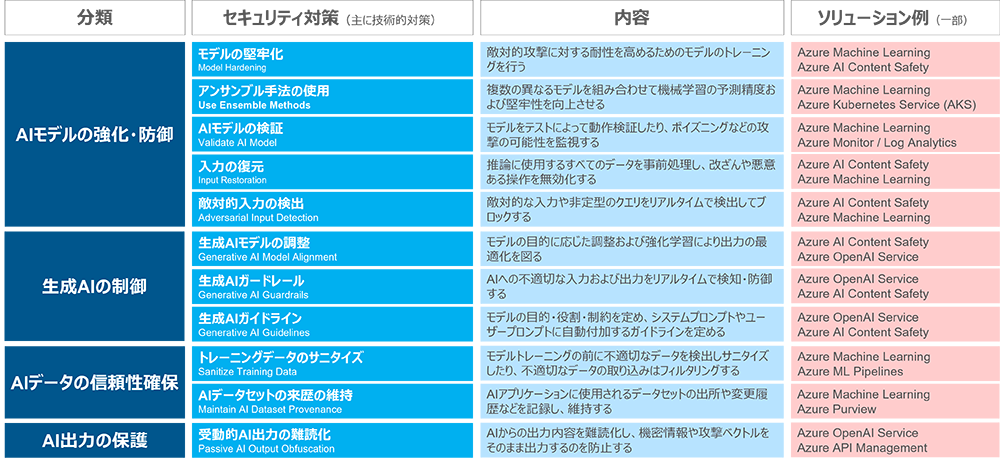

1)AIモデルやAIデータに関するセキュリティ対策

一つ目のカテゴリ「Technical - ML」(テクニカル - 機械学習)の緩和策は、AIモデルやAIデータに関するセキュリティ対策といえます。さらに分類すると、AIモデルの強化・防御、生成AIの防御、AIデータの信頼性確保、AI出力の保護の4つに分けられます。これらは、AIの中核となるコンポーネントのセキュリティ対策であり、最後の砦ともいえる緩和策です。

例えば、OWASP Top 10 For LLM Applications 2025で1位に挙げられているプロンプトインジェクション(Prompt Injection)に対するセキュリティ対策は、MITRE ATLASでは、生成AIの防御に分類されるセキュリティ対策(生成AIモデルの調整、生成AIガードレール、生成AIガイドライン)が対応しています。また、同じく4位に挙げられているデータおよびモデルのポイズニング(Data and Model Poisoning)に対するセキュリティ対策は、AIモデルの強化・防御やAIデータの信頼性確保に分類されるセキュリティ対策(モデルの堅牢化、アンサンブル手法の使用、AIモデルの検証、入力の復元、敵対的入力の検出、トレーニングデータのサニタイズ、AIデータセットの来歴の維持)が対応しています。

なお、参考例として、図3にMicrosoft社クラウドサービスのソリューションの一部を示します。これらで該当するソリューションがすべて網羅されているわけではなく、今後、機能追加や変更が生じる可能性があることにご注意ください。

図3:AIモデルやAIデータに関するセキュリティ対策

(分類およびソリューション例は筆者記載)

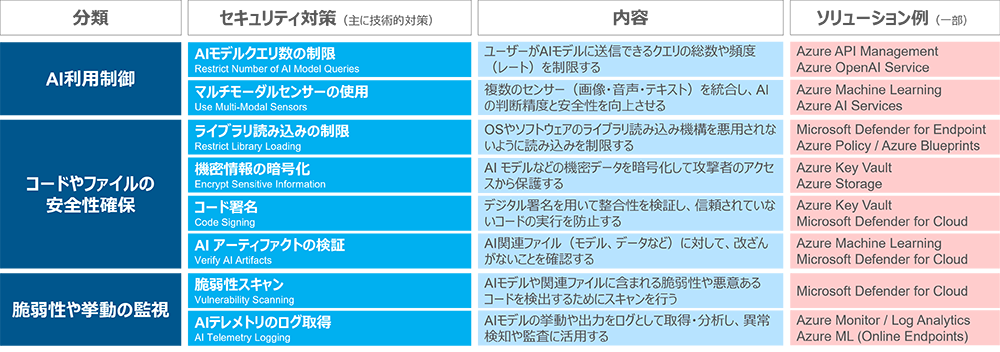

2)AIのITインフラに関するセキュリティ対策

二つ目のカテゴリ「Technical - Cyber」(テクニカル – サイバー)に分類された緩和策は、AIのITインフラに関するセキュリティ対策となります。さらに分類すると、AI利用制御、コードやファイルの安全性確保、脆弱性や挙動の監視に分けられます。これらは、AIの基盤となるITインフラのセキュリティ対策であり、多層防御の観点で重要な位置づけとなる緩和策です。

例えば、OWASP Top 10 For LLM Applications 2025で2位に挙げられている機密情報の漏洩(Sensitive Information Disclosure)に対するセキュリティ対策は、MITRE ATLASでは、AI利用制御および脆弱性や挙動の監視に分類されるセキュリティ対策(AIモデルクエリ数の制限、AIテレメトリのログ取得)が対応しています。なお、MITRE ATLASのすべての緩和策のうち、最も多くのテクニックに対応しているとされる緩和策は、AIモデルクエリ数の制限およびAIテレメトリのログ取得です。AIモデルクエリ数の制限は、攻撃者がAIモデルに送信できるクエリの総数や頻度を制限することによって攻撃能力を低下させる対策です。AIテレメトリのログ取得は、AIモデルの挙動や出力をログとして取得・分析し、異常検知や監査に活用することで幅広い攻撃をモニタリングする対策です。

ここでも参考例として、図4にMicrosoft社クラウドサービスのソリューションの一部を示します。

図4:AIシステムのインフラに関するセキュリティ対策

(分類およびソリューション例は筆者記載)

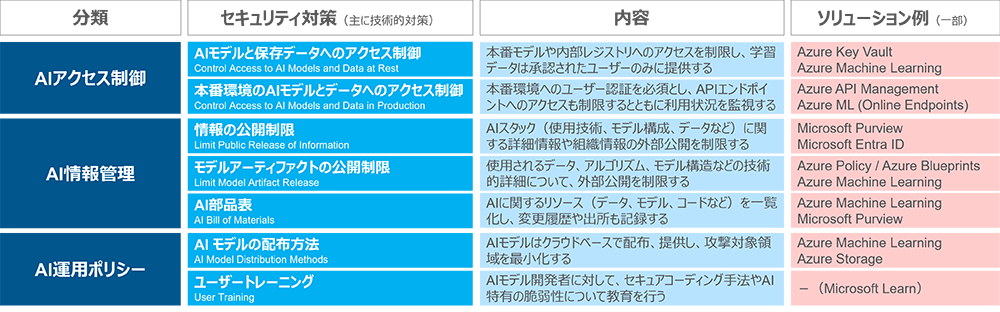

3)AI運用に関するセキュリティ対策

三つ目のカテゴリ「Policy」(ポリシー)に分類された緩和策は、AIの運用に関するセキュリティ対策となります。さらに分類すると、AIアクセス制御、AI情報管理、AI運用ポリシーに分けられます。技術的対策だけでなく管理的対策も一部含まれていますが、これらはAIの実装および運用に関する重要な緩和策です。

これらの緩和策のうち、AI部品表は、AIに関するリソース(データ、モデル、コードなど)を一覧化し変更履歴や出所も記録しておくことを目的としています。また、ここでいうユーザートレーニングは、基本的にはAIモデル開発者向けのセキュアコーディングやAI特有の脆弱性に関する教育を目的としていますが、一般ユーザー向けのAIに関するセキュリティ教育も含めて良いと思います。

ここでも参考例として、図5にMicrosoft社クラウドサービスのソリューションの一部を示します。

図5:AI運用に関するセキュリティ対策

(分類およびソリューション例は筆者記載)

4. その他の生成AIセキュリティに関する参考情報

ここまでMITRE ATLASをベースに生成AIのセキュリティ対策を見てきましたが、実務に関わる立場によってはもっと踏み込んだ情報を必要としている場合もあると思います。

- •一つ一つ段取りを踏まえて生成AIのセキュリティ対策を検討し網羅性を高めたい。

- •生成AIのセキュリティ対策を考えるうえで、もっと具体化・詳細化した情報が欲しい。

こういった立場の考え方のためにいくつかの参考情報をご紹介します。

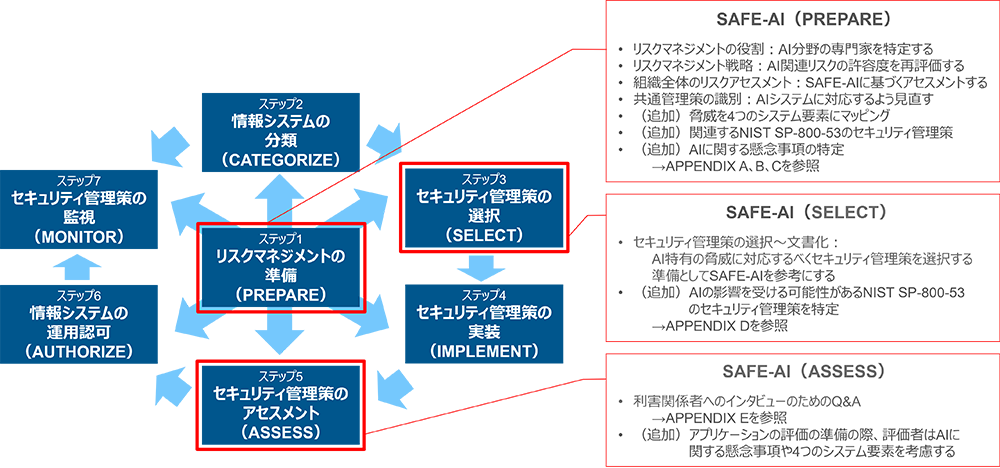

1)SAFE-AI(A Framework for Securing AI-Enabled Systems)

段取りおよび網羅性を考慮した生成AIのセキュリティ対策検討には、MITRE ATLASの中の公開資料SAFE-AI A Framework for Securing AI-Enabled Systemsが参考になります。SAFE-AIは、NIST SP 800-37 Rev. 2(NISTリスクマネジメントフレームワーク(RMF))をベースとしてAI特有の脅威および懸念事項を体系的に特定し対処することで、セキュリティ対策を選択し評価するプロセスを強化することを目指したものです。なお、ここでいう評価(ASSESS)とは、既存のセキュリティ対策の有効性を評価することです。図6にNISTリスクマネジメントフレームワークのどの部分にSAFE-AIが関係するのかを示します。

図6:NISTリスクマネジメントフレームワークとSAFE-AI

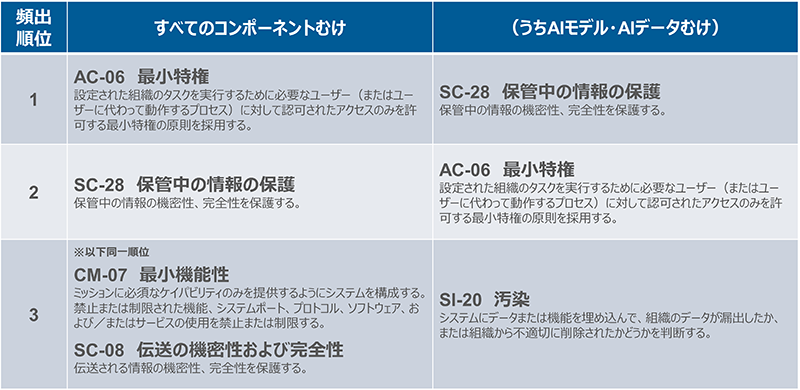

SAFE-AIで特に参考になるのは、同書のAPPENDIX C(AIの脅威、懸念事項および残留リスク)です。APPENDIX Cでは、AIシステムを、環境、AIプラットフォーム、AIモデル、AIデータの4つのシステム要素に大別し、それぞれのセキュリティ脅威に対してNIST SP800-53 Rev5のセキュリティ管理策の例や、関連する補足事項を示してくれています。なお、最も頻出するセキュリティ管理策のトップ3は図7の通りです。各セキュリティ管理策の実装方法は、NIST SP800-53 Rev5を確認しながら個別に考える必要があります。

図7:SAFE-AIで頻出する主なセキュリティ管理策(NIST SP800-53 Rev5ベース)

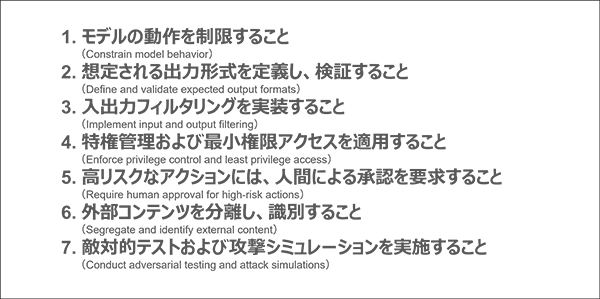

2)OWASP Top 10 For LLM Applications

生成AIセキュリティ対策の具体化・詳細化については、OWASP Top 10 For LLM Applications 2025の本文が参考になります。本書では、Top10のすべての項に防止および緩和戦略(Prevention and Mitigation Strategies)が書かれおり、それぞれ複数のセキュリティ対策およびその説明が盛り込まれています。例えば、プロンプトインジェクションに対する防止および緩和戦略は、図8の通りとなっています。

ただし、OWASP Top 10 For LLM Applicationsは、深刻で優先度の高いセキュリティ脅威にフォーカスしているため、MITRE ATLASのすべてのセキュリティ脅威を網羅しているわけではないことに注意が必要です。

図8:プロンプトインジェクションに対する防御および緩和戦略(OWASP)

なお、同じOWASPから公開されているAI Exchange(OWASP AI Security and Privacy GuideにおけるAIセキュリティの部分)も対策具体化の参考になります。本サイトでは、AIシステムの利用時、開発時、実行時それぞれのタイミングのセキュリティ脅威と、それに対応したセキュリティ対策が記載されています。ただし、こちらはコミュニティベースで更新されているため、情報が体系性に整理されていないことをご認識ください。

まとめ

第2回では、AI共有責任モデルやMITRE ATLASなどを用いて特に技術的観点で生成AIのセキュリティ対策について解説しました。

AI技術は急速に進化しており、AIシステムを守るセキュリティソリューションは、今後もさまざまなものが提供されていくと考えられます。また、AIセキュリティ対策の標準化も順次進められており、こちらも今後の発展が期待されるところです。生成AIのセキュリティには、自社でできる対策と、事業者に頼る対策をうまく識別して対処することが望まれます。

関連サービス

- INTELLILINK AIセキュリティ診断 for LLMアプリケーション

LLMアプリケーションのセキュリティ対策を支援する「INTELLILINK AIセキュリティ診断 for LLMアプリケーション」を開始 | 株式会社NTTデータ先端技術 - AIガバナンスコンサルティングサービス

AIガバナンスコンサルティングサービス | 株式会社NTTデータ先端技術 - INTELLILINK リスク分析サービス

INTELLILINK リスク分析サービス | 株式会社NTTデータ先端技術 - INTELLILINK Webアプリケーションマネージド診断サービス

INTELLILINK Webアプリケーションマネージド診断サービス | 株式会社NTTデータ先端技術 - INTELLILINK Azure OpenAI Service環境提供

INTELLILINK Azure OpenAI Service環境提供 | 株式会社NTTデータ先端技術

参考文献

- [1]MITRE ATLAS The MITRE Corporation

- [2]MITRE ATT&CK The MITRE Corporation

- [3]AI共有責任モデル(AI shared responsibility model) Microsoft Corporation

- [4]AI 事業者ガイドライン(第1.1版) 総務省・経済産業省

- [5]OWASP Top 10 For LLM Applications 2025 OWASP Foundation

- [6]OWASP AI Security and Privacy Guide OWASP Foundation

- [7]AI Exchange OWASP Foundation

- [8]SAFE-AI:A Framework for Securing AI-Enabled Systems The MITRE Corporation

- [9]Artificial Intelligence Risk Management Framework (AI RMF 1.0) NIST(米国立標準技術研究所)

- [10]NIST SP 800-37 Rev. 2(日本語訳) 独立行政法人情報処理推進機構(IPA)

- [11]NIST SP 800-53 Rev. 5 (日本語訳) 独立行政法人情報処理推進機構(IPA)

- [12]NISTのリスクマネジメントフレームワーク(RMF)とは ~第1回 SP800-37 Rev2とリスクマネジメントフレームワーク(RMF)~ 株式会社NTTデータ先端技術

- [13]NISTのリスクマネジメントフレームワーク(RMF)とは ~第2回 準備~分類~選択~ 株式会社NTTデータ先端技術

- [14]NISTのリスクマネジメントフレームワーク(RMF)とは ~第3回 実施~アセスメント~運用認可~監視~ 株式会社NTTデータ先端技術

- [15]Best Practices for Securing Data Used to Train & Operate AI Systems CISA(米国サイバーセキュリティ・インフラ庁)

- ※文中の商品名、会社名、団体名は、一般に各社の商標または登録商標です。