AI活用ルール策定のススメ(リスク編)

今回はAI活用における主なリスクについて説明したいと思います。

リスク管理部門責任者。口癖はジャスティス。コスプレが大好き。

ザリガニ事業部のベテラン技術者(なんでも屋)。お酒が大好き。

イロイロとこじらせたまま中年になってしまった謎のイカ。ゲームが大好き。

えーと。「あなたはAIゲームビジネスのスペシャリストです。AIでゲーム内通貨を荒稼ぎするやり方を教え……」

コラコラコラ!何をAIに聞いとんねんコラ!

いや。なんでも教えてくれるから面白くてつい……

やっぱり自由に使わせるとこうなるわね……

ファインチューニングか、リスクの理解や教育、ルールが必要ね……

じゃ今回は軽くリスク周りについて説明していこか。

AI利活用におけるリスクってなんだ?

AI利活用は業務効率化、コスト削減、新たな価値創造など多くのメリットをもたらす一方、さまざまな潜在的リスクも存在します。今回は組織がAI活用を検討・導入する際に考慮すべきリスクについて解説します。

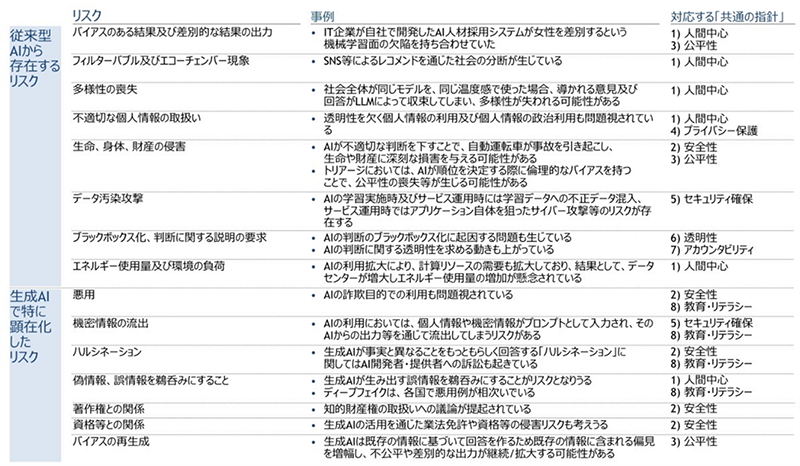

総務省・経産省から公開されている「AI事業者ガイドライン」[1] は、AI利活用における一般的なリスクについても記載されており、別添資料[2][3]ではより具体的に次のようにまとめてあります。

- ※それぞれ簡単に説明をしますが、全てのリスクを網羅的にまとめたものではなく、あくまで一例としての記載です。

表1:AIによる便益/リスク(AIによるリスク)[2][3]

バイアスのある結果及び差別的な結果の出力 (人間中心、公平性)

AIにおけるバイアスとは、不公平であるとか差別、偏った偏見の出力結果という意味合いで使われることが多く、AI活用において最も困難な課題の一つとして完全な解消は難しいとされている事象になります。

例えばIT企業が自社でAI人材採用システムを開発したが、女性を差別するという機械学習面の欠陥が判明し、その原因としては学習に使用した過去10年間の履歴書において、応募者のほとんどが男性であったことから、男性を採用することが好ましいとAIが認識したためと言われています。

当該企業は、女性を差別しないようにプログラムの改善を試みたものの、別の差別を生むとして運用を取りやめる結果になりました。バイアスが起こりやすい要素として他にも人種、民族、宗教、障害の有無、LGBTQ、年齢、容姿など様々なものがあります。

フィルターバブル及びエコーチェンバー現象(人間中心)

フィルターバブルとは、インターネット上での活動や検索履歴に基づいて、アルゴリズムがユーザーに対して特定の情報やコンテンツを優先的に表示する現象を指します。これにより、ユーザーは自分の興味や関心に合った情報ばかりを目にするようになり、異なる視点や意見に触れる機会が減少し、極端な考えの持ち主になる懸念も指摘されています。フィルターバブルの影響には次のようなものがあります。

- 1.情報の偏り

特定の意見や視点に偏った情報を受け取ることが多くなり、意識的・無意識的に同じような意見を強化することになります。例えば、政治的に偏ったニュースだけを見続けることで、その視点に固執するようになり、反対の立場に対する理解が不足することがあります。 - 2.社会的な分断

特に社会的・政治的な問題において、フィルターバブルは異なる意見を持つ人々との対話を難しくし、社会の分断を深める可能性があります。異なる立場の人々が全く異なる情報を受け取り、共通の認識を持たなくなることが、社会的対立を激化させる要因となり得ます。 - 3.見識の狭さ

ユーザーが自分の興味に合ったコンテンツだけを消費するため、視野が狭まり、広範な知識や新しい考え方を学ぶ機会が減ります。特に学習・成長の機会が制限され、偏った意見や誤った情報に影響されやすくなります。

エコーチェンバーは、同じ意見や信念を持つ人々が集まり、互いにその意見を強化し合う環境を指します。これにより、特定の見解が繰り返し反響し、他の意見や反論が排除されることが多くなります。エコーチェンバーは、ソーシャルメディアやオンラインコミュニティで特に顕著です。エコーチェンバーの影響には次のようなものがあります。

- 1.極端な意見の形成

エコーチェンバー内では、意見が過激化しやすく、理性的な議論が困難になることがあります。これにより、偏った情報や誤った信念が強化され、意見の極端化が進みます。 - 2.誤情報の拡散

エコーチェンバーは、事実に基づかない情報や陰謀論、フェイクニュースが拡散されやすい環境です。特に、反対意見が排除されるため、誤った情報が真実として認識され、社会的な混乱を引き起こすことがあります。 - 3.社会的対立の激化

エコーチェンバーが存在すると、異なる意見を持つグループ間での対話が難しくなります。結果的に、社会全体で意見の対立が激化し、コミュニケーションの質が低下することになります。

多様性の喪失(人間中心)

社会全体が同じようなAIを同じような用い方で使った場合、導かれる意見及び回答が偏ったものになり、多様性が失われる可能性があります。具体的には次のような懸念があります。

- 1.データの偏り

AIは学習するデータに基づいて意思決定を行いますが、そのデータが偏っている場合、AIの判断も偏りがちです。例えば、AIがトレーニングされたデータセットに特定の性別、民族、年齢層の情報が少ない場合、そのグループに対する認識が誤ったり、無視されたりすることがあります。この結果、AIの意思決定がある特定の集団に不利に働くことがあり、社会的な多様性を反映することが難しくなります。 - 2.アルゴリズムの設計の偏り

AIを開発する際、設計者自身の価値観や視点が反映されることがあります。特定の文化的背景や社会的慣習を前提にしたアルゴリズムが開発されると、そのアルゴリズムは他の文化や社会に適応できない可能性があり、これが多様性の喪失を引き起こします。例えば、ある国で使われるAIシステムが、異なる国の価値観や法律に適していないことがあります。 - 3.ユーザーの多様性への配慮不足

AI技術が広く普及する中で、ユーザーの多様性に対する配慮が不十分だと、特定のユーザー層に対して不公平が生じる可能性があります。例えば、AIベースの医療診断や雇用選考で、特定の年齢層、性別、または民族グループが過小評価されると、その集団のニーズや特性に合った対応ができなくなります。 - 4.文化的な影響

AI技術は世界中で使用されていますが、異なる文化や地域ごとのニーズに対応するのは容易ではありません。例えば、言語や宗教、慣習など、文化的背景が異なる地域では、AIが意図しない形で問題を引き起こすことがあります。特定の文化や価値観を反映したAIは、その文化を超えて多様なニーズに対応することができなくなります。

不適切な個人情報の取扱い(プライバシー保護、人間中心)

AI活用における不適切な個人情報(個人データ)の取り扱いは、データのプライバシーやセキュリティに関する様々な問題を引き起こす可能性があります。具体的には次のようなものがあります。

- 1.無断収集

個人情報(個人データ)を収集する際、ユーザーの明確な同意なしにデータを集めることは不適切です。特にAIシステムが提供するサービスがユーザーに対してプライバシーポリシーや利用規約を適切に提示しないまま個人データを取得した場合、法的な問題を引き起こす可能性があります。例えばユーザーが明示的に同意していないデータ(位置情報やオンライン活動履歴など)を収集する行為はプライバシー侵害に該当する可能性が高くなります。 - 2.データの過剰収集

AIシステムがユーザーの個人情報(個人データ)を必要以上に収集する場合も問題です。例えば、サービス提供の目的に必要な範囲を超えて不必要な情報を収集したり、長期間にわたり保存したりすることは、個人情報(個人データ)を過剰に扱うことになり、リスクを高めます。これにより、ユーザーのプライバシーが侵害される可能性があります。 - 3.データの無断共有・販売

AI技術を活用したサービスにおいて、ユーザーの個人情報(個人データ)を第三者に無断で共有したり、販売したりすることは深刻な問題です。例えば、データを収集した企業が、そのデータを他の企業に販売することで、ユーザーが知らぬ間に個人情報(個人データ)が広がり、意図しない使われ方をされることがあります。 - 4.不十分なデータ保護

個人情報(個人データ)を保存・処理するAIシステムが不十分なセキュリティ対策を採用している場合、データが漏洩するリスクがあります。例えば、サーバーのセキュリティが脆弱であると、ハッカーによるデータ盗難や不正アクセスが発生し、個人情報(個人データ)が外部に流出する可能性があります。このような事例は、個人情報(個人データ)を扱う組織にとって大きな信頼の喪失を招きます。 - 5.アルゴリズムによる個人情報(個人データ)の誤用

AIアルゴリズムが個人情報(個人データ)を元に予測や判断を行う際に、誤った解釈をすることがあります。例えば、個人情報(個人データ)を基にしたAIが人種、性別、年齢などの特定の属性に基づいて偏った判断を下す場合、AIの活用が不公正な扱いや差別につながることがあります。このような場合、個人情報(個人データ)が不適切に利用されることになります。 - 6.匿名化・非識別化の不十分さ

AIシステムで個人情報(個人データ)を扱う場合、その情報を匿名化または非識別化することが一般的に推奨されています。しかし、このプロセスが不十分であると、個人情報(個人データ)が容易に再識別され、プライバシーが侵害される危険性があります。例えば、匿名化されたデータが他の情報と組み合わせることで個人を特定できてしまう場合があります。 - 7.ユーザーの権利を無視したデータ利用

個人情報(個人データ)に関しては、ユーザーに特定の権利(アクセス権、訂正権、削除権、データの移植権など)が付与されています。AIシステムがこれらの権利を無視して、ユーザーが自身のデータを確認したり、修正したり、削除したりすることができない場合、法的に問題が発生する可能性があります。

生命・身体・財産の侵害(安全性、公平性)

AI活用において生命・身体・財産の侵害におけるリスクについて、現状で次のようなものが考えられます。

- 1.生命に対するリスク

- ・自動運転車

自動運転車はAI技術を利用して周囲の状況を把握し、運転を行いますが、システムの不具合や誤動作によって事故が発生する可能性があります。例えば、AIが歩行者や他の車両を誤認識したり、複雑な状況で適切に判断できない場合、重大な交通事故を引き起こすことがあります。これにより、乗車者だけでなく、周囲の人々の生命も危険にさらされることになります。 - ・医療AI

AIを活用した診断支援システムやロボット手術技術が導入されることにより、医療分野でのリスクも存在します。AIが誤った診断や治療法を提案した場合、患者の健康や命に直接的な影響を与える可能性があります。また、手術ロボットの不具合が手術中に発生した場合、患者の命に関わる問題が生じることも考えられます。

- ・自動運転車

- 2.身体に対するリスク

- ・ロボットと人間のインタラクション

産業用ロボットや介護ロボットが人と直接接触する場面では、誤った動作や故障により人間に怪我を負わせるリスクがあります。例えば、工場の製造ラインで使用されるロボットが、予期せぬ動作を行った場合に作業員が負傷する可能性があります。また、介護ロボットが誤って利用者を傷つけることも考えられます。 - ・ドローン

ドローン技術を活用することで、物流や配送の効率化が進んでいますが、ドローンが誤って人に衝突したり、制御不能になって他の物体に当たることがあります。特に、大きなドローンが高い高度から急降下してきた場合、重大な怪我を引き起こすリスクが伴います。 - ・人体への誤った影響(医療AIやウェアラブルデバイス)

医療機器やウェアラブルデバイスのAIによる誤ったデータ解析やフィードバックも身体的リスクをもたらします。例えば、心拍数モニタリングデバイスが異常を誤って検出した場合、無駄な治療が行われるか、逆に必要な治療が見逃される恐れがあります。

- ・ロボットと人間のインタラクション

- 3.財産に対するリスク

- ・サイバー攻撃による財産損失

AI技術を活用したシステムは、サイバー攻撃やハッキングのターゲットとなることがあります。AIシステムが企業や金融機関で使用されている場合、攻撃者がAIを悪用してシステムを操作し、不正な取引やデータ改ざんを行うことがあります。これにより、顧客の財産が盗まれたり、企業の資産が危険にさらされたりする可能性があります。 - ・AIによる投資のリスク

AIが株式市場や金融取引に活用されている中で、AIに基づいた自動取引システムが予測に失敗した場合、大規模な経済的損失が発生するリスクがあります。AIは大量のデータを分析し、取引を迅速に行いますが、異常な市場状況や予測できない事態に対して適切に反応できない場合、投資家の財産に大きな影響を与える可能性があります。 - ・AIによる詐欺

AIを活用した偽造や詐欺行為も問題となることがあります。例えば、AIが個人情報を悪用して金融詐欺やクレジットカード不正利用を行うケースです。また、AIによる顔認証技術や音声認識技術を悪用した詐欺も発生する可能性があり、財産的な損失を引き起こします。

- ・サイバー攻撃による財産損失

データ汚染攻撃(セキュリティ確保)

AIシステムの学習データに悪意のあるデータを意図的に追加し、その後の学習プロセスに干渉する攻撃方法です。このような攻撃は、AIシステムが正しい予測や判断を行えなくなるようにデータを「汚染」することを目的とし、ときに重大なリスクを引き起こす可能性があります。現状で次のようなものが考えられます。

- 1.AIシステムの性能低下

データ汚染攻撃によって、AIモデルは誤った情報を学習し、その結果、予測精度が大きく低下します。例えば、AIモデルが重要な特徴を誤って学習したり、異常なデータパターンを学習してしまうことで、システム全体の信頼性が損なわれる可能性があります。- ・医療診断AIが誤ったデータを学習し、診断結果が不正確になったり、特定の疾患を見逃したりするリスクがあります。

- ・金融機関のAIシステムが不正確な取引データを学習し、リスクの高い取引を適切に検出できなくなる恐れがあります。

- 2.誤った予測や判断

攻撃者が意図的にデータを汚染することで、AIは誤った予測や判断を下すようになります。特に、AIが重要な意思決定を行う場面では、このような誤った判断が直接的な損害を引き起こす可能性があります。- ・自動運転車のAIシステムが、攻撃によって道路標識や障害物を誤認識することで、交通事故を引き起こすリスクがあります。

- ・顔認証システムが誤って個人を認識できない、または他人を誤って認識することで、セキュリティ上の問題が発生することがあります。

- 3.AIシステムの悪用

攻撃者がデータ汚染攻撃を使って、AIシステムを自分の目的に悪用することも可能です。例えば、攻撃者がAIモデルを使ってターゲットを誤って評価させたり、不正な行動を取らせたりすることがあります。- ・選挙予測AIが攻撃され、特定の候補者を誤って高く評価させ、選挙結果に影響を与える可能性があります。

- ・価格予測AIが汚染され、攻撃者が競合企業に有利な価格設定を行わせるように仕向けることがあります。

- 4.システムのセキュリティリスク

データ汚染攻撃によって、AIシステムのセキュリティが脆弱になる場合もあります。攻撃者は、AIの判断や学習プロセスに干渉し、システムの動作を不正に操作することができます。- ・サイバーセキュリティシステムがデータ汚染攻撃を受けて、攻撃を正確に検出できなくなり、サイバー攻撃が成功する可能性が高まります。

- ・金融AIが攻撃者によって操作され、詐欺的な取引が見逃されるリスクがあります。

ブラックボックス化、判断に関する説明の要求(透明性、アカウンタビリティ)

AI判断のブラックボックス化とは、AIシステムの決定プロセスが外部からは理解しにくく、解釈や説明が難しい状態を指します。つまり、AIがどのようにして特定の判断を下したのかが透明でないため、その決定をユーザーや開発者が完全に理解できない状況です。ブラックボックス化が問題となる理由は以下のような点です。

- 1.責任の所在が不明確

例えば、AIが誤った判断をした場合、その責任がどこにあるのかが不明確になることがあります。AIの決定が誰によってどのように導かれたかがわからないため、誤った決定の原因を特定するのが困難です。 - 2.信頼性の問題

AIの判断が「なぜそのような決定をしたのか」が理解できない場合、その判断を信頼できるかどうかの判断も難しくなります。特に重要な決定がAIに委ねられる場合、透明性が欠如していると問題となります。 - 3.倫理的懸念

AIが倫理的に問題のある判断をする場合、その根拠がブラックボックスの中に隠れていると、どのような倫理的基準に基づいているのかを説明できません。例えば、AIによる差別的な判断が行われた場合、その背景を解明するのは難しいことがあります。 - 4.規制やガバナンスの難しさ

ブラックボックス化されたAIに対しては、適切な規制を導入するのが難しく、企業や政府がその利用を適切に監督することが困難になります。

エネルギー使用量及び環境の負荷(人間中心)

AIの利用に伴うエネルギー使用量と環境への負荷は、特に大規模なAIモデル(例えば、ディープラーニングを用いたモデル)の運用において重要な問題として取り上げられています。以下は、AI利用によるエネルギー使用量と環境への影響に関するいくつかのポイントです。

- 1.AIモデルのトレーニングにかかるエネルギー

AI、特に深層学習モデルのトレーニングは非常にエネルギーを消費します。大規模なモデルをトレーニングするためには、膨大な計算リソース(GPUやTPUなど)を長時間使用する必要があり、これがエネルギー消費の大きな原因となります。例えば、自然言語処理や画像認識の大規模なAIモデルを訓練する際には、数日から数週間にわたる大量の計算が行われ、その間に消費される電力が膨大になります。 例えば、ある大型AIモデル(例えばGPT-3)のトレーニングにかかる電力は、数十万kWhを超えることがあり、これは一般的な家庭での年間の電力使用量に匹敵することもあります。 - 2.データセンターのエネルギー消費

AIの運用には、モデルのトレーニングだけでなく、推論(実際にAIを使って予測や判断を行うこと)を行うためのデータセンターも重要な役割を果たします。データセンター内では、AIモデルのデプロイやユーザーからのリクエストに応じた処理が行われ、これには膨大な計算能力が必要です。

データセンターは高いエネルギー消費を伴い、冷却システムにも多くのエネルギーを使うため、運用における環境への負荷は大きいです。特にAIの処理能力を高めるために使われる大量のGPUやその他のハードウェアは、冷却を含めて膨大な電力を消費します。 - 3.AIの推論にかかるエネルギー

AIが稼働中に行う推論(予測など)は、トレーニングと比較するとエネルギー消費は少ないものの、依然として大きな電力を消費します。例えば、AIを用いたリアルタイムのサービス(音声認識や画像認識、自然言語処理など)は、リクエストごとにエネルギーを消費し、その積み重ねが環境負荷を高める可能性があります。 - 4.環境への負荷

AIのトレーニングや運用に伴うエネルギー消費は、主に化石燃料による発電によって供給されている場合、そのCO₂排出量が環境に大きな影響を与えることになります。特に、再生可能エネルギーが普及していない地域で運用されるAIシステムでは、温室効果ガスの排出が増加し、気候変動に対する影響が懸念されます。 - 5.AIとエネルギー効率

AIはその一方で、エネルギー効率を改善する可能性も持っています。例えば、AIを使ってエネルギー消費を最適化する方法(スマートグリッド、建物や工場のエネルギー管理システムなど)を開発することができます。AIを利用した効率的なエネルギー使用や省エネルギー技術の開発は、環境負荷を減少させる手段の一つとなります。 - 6.AIによる環境負荷低減の可能性

企業やデータセンターは、AIを利用してエネルギーの消費を効率化するだけでなく、再生可能エネルギーの利用を積極的に進めています。AIを用いて発電の最適化を行うことにより、再生可能エネルギーの利用率が向上することも期待されています。

AIは環境監視や気候変動の予測にも利用され、環境への負荷を減らすための政策や行動を促進する役割を果たすことができます。例えば、AIを使った森林監視、気象予測、汚染物質の検出などが行われています。

機密情報の流出(セキュリティ確保、教育・リテラシー)

AIは膨大なデータを学習し、判断や予測を行うため、その過程で個人情報(個人データ)や企業の機密情報が不適切に扱われたり、流出したりするリスクがあります。以下は、そのリスクと関連する要素について詳しく説明します。

- 1.データ収集とプライバシーの問題

AIシステムを訓練するためには、大量のデータが必要です。このデータには個人情報(個人データ)や機密情報が含まれている場合があります。例えば、ユーザーの行動履歴、健康データ、財務データなどがAIシステムに供給されることがあります。問題となるのは、これらのデータがどのように収集され、管理され、保護されているかです。

個人情報(個人データ)が不正に収集されたり、許可なく使用されたりすることはプライバシー侵害のリスクを生じます。個人が同意していない方法で収集されたデータがAIによって分析され、その結果として個人情報(個人データ)が漏洩する可能性があります。 - 2.AIシステムのトレーニングデータのリスク

AIが学習に使用するデータセットには、機密情報が含まれることがあります。例えば、企業の内部データや個人情報(個人データ)がトレーニングデータに含まれている場合、その情報が学習の過程でAIのモデルに組み込まれ、結果としてモデルの推論に使われることがあります。

AIモデルは非常に強力な推論能力を持つため、トレーニングデータに含まれる機密情報を間接的に「記憶」することがあります。これが「逆推論」のリスクとなり、モデルを利用することで、ユーザーや企業の機密情報が漏れる可能性があります。例えば、特定の入力に対してAIが過去のデータを反映させた回答を出す場合、そこから元の機密情報が漏洩することがあります。 - 3.データの流出リスク

AIシステムがデータを収集、処理、保存する過程で、セキュリティの不備があれば、個人情報(個人データ)や機密情報が流出するリスクがあります。このリスクは、特に次のような場面で顕著です。- ・不正アクセス

サイバー攻撃者がAIシステムやそのデータベースに不正アクセスし、個人情報(個人データ)や機密情報を盗み出すリスクがあります。AIシステムは非常に多くのデータを扱うため、そのデータが集約されている場所が攻撃対象となりやすいです。 - ・不十分な暗号化

データが適切に暗号化されていない場合、AIシステムが処理するデータが盗聴されるリスクが高まります。通信経路や保存場所で暗号化されていない情報は、外部からアクセスされることで流出する可能性があります。

- ・不正アクセス

- 4.外部サービスとのデータ共有

AIシステムが外部のクラウドサービスや他のシステムと連携してデータを共有する場合、そのデータの取り扱いが問題になることがあります。例えば、AIの学習データや推論結果を外部に送信している場合、第三者のセキュリティ体制が不十分であれば、その情報が流出するリスクが高まります。

AIを提供する企業やクラウドサービスプロバイダーとの契約条件によって、どのようにデータが扱われるかが異なります。ユーザーがその取り決めに無関心であると、個人情報(個人データ)や機密情報が予期しない方法で使用されることがあるため、透明性と適切な契約が重要です。 - 5.AIと法規制

個人情報(個人データ)の保護に関しては、各国でさまざまな法律が存在します。例えば、欧州のGDPR(一般データ保護規則)やアメリカのCCPA(カリフォルニア消費者プライバシー法)などがあり、AIが収集したデータがこれらの法律に抵触しないようにする必要があります。

AIシステムが法的に適切に動作していることを確保するためには、データの収集、処理、保護について明確なルールを設け、遵守する必要があります。 - 6.AIシステムの改善と監視

AIを運用する際、定期的な監視と評価が必要です。AIシステムの運用後にデータ流出や誤用が発生するリスクを低減するためには、継続的な監視体制とセキュリティの強化が不可欠です。AIの利用に関するセキュリティを強化するためには、AIシステムやそのデータベースへのアクセス制限を強化し、暗号化や多要素認証などのセキュリティ対策を講じることが重要になってきます。

悪用(安全性、教育・リテラシー)

AIはその能力を悪用することで、人々を騙したり、金銭的利益を不正に得たりするために利用されるリスクがあります。その具体的な手法について説明します。

- 1.ディープフェイク(Deepfake)

ディープフェイク技術は、AIを使用して人物の顔や声をリアルに合成する技術です。この技術を利用すると、実際には言っていないことを誰かが言っているように見せかけることができ、また、存在しない映像や音声を作成することも可能です。

AIを使って有名人や企業のCEO、政治家などの顔や声を模倣し、偽のメッセージを作成することができます。例えば、企業のトップを模倣して部下に不正な金銭を送金させる「ビジネスメール詐欺」が行われることがあります。 - 2.AIを使ったフィッシング詐欺

フィッシング詐欺は、偽のウェブサイトやメールを使って個人情報(個人データ)やログイン情報を盗み取る手法ですが、AIを利用することでこれがより高度化しています。

AIは、ターゲットに対してより個別化された、よりリアルなフィッシングメッセージを生成することができます。例えば、AIはターゲットの過去の行動を分析し、その人が最も反応しやすい内容のメッセージを自動的に作成することができます。また、AIは、個々のターゲットに合わせてメッセージをパーソナライズできるため、フィッシング詐欺の成功率が高くなり、詐欺師が個人情報(個人データ)や金融情報を盗み取る確率が増加します。 - 3.AIによる自動化されたスパムと詐欺活動

AIを活用することで、スパムメールや詐欺メッセージの送信を自動化することが可能です。これにより、詐欺師は大規模な詐欺キャンペーンを効率的に展開できるようになります。

AIは大量のスパムメールを生成し、ターゲットに送り続けることができます。AIを用いて詐欺メッセージの内容を最適化し、特定のターゲット層により効果的にアプローチすることができます。

例えば、AIを用いたスパムメールの内容をターゲットの行動や関心に合わせて変更し、より説得力のあるメッセージを送り、受信者が引っかかりやすくすることが可能です。 - 4.詐欺的なAI生成コンテンツの販売

AI技術は、偽のレビューや虚偽の評価、または偽の商品説明を生成するためにも利用されます。これにより、消費者が購入を決定する際に誤った情報を与えることができます。

AIを使って大量の偽レビューや評価を自動的に生成し、商品の評判を不正に操作することができます。例えば、AIが偽の高評価レビューを作り出し、消費者に商品を購入させることができます。

また、AIによって作成された偽の商品説明や広告が、消費者に対して虚偽の情報を提供し、不正な販売が行われることがあります。 - 5.AIを使った自動化詐欺(ボットによる詐欺)

AIを利用した自動化された詐欺ボットは、金融詐欺やソーシャルエンジニアリングに使われることがあります。

AIを用いて高速で大量の金融取引を行い、仮想通貨の取引所や株式市場で不正な利益を得ることができます。これにより、正規の取引者が騙されて損失を被るリスクが高まります。

AIボットは、人々とのやりとりを模倣する能力があり、SNSやメッセージングアプリで詐欺行為を行うことができます。例えば、AIを使ってSNS上で偽のアカウントを作り出し、詐欺的な投資話や信頼できる人物を装って情報を引き出すことができます。 - 6.AIによる自動化された攻撃(サイバー犯罪)

AIを使ってサイバー犯罪を行う手法も増えています。AIは、システムの脆弱性を検出し、それを利用した攻撃を自動化することができます。

AIは、システムやネットワークの脆弱性を探し出し、それを自動的に攻撃することができます。これにより、詐欺師はターゲットを選んで攻撃を行うことができ、被害を広範囲にわたるものにする可能性があります。

ハルシネーション(安全性、教育・リテラシー)

AIにおけるハルシネーション(幻覚)リスクとは、AIモデル(特に大規模な言語モデルや生成モデル)が「誤った情報」や「虚偽の事実」を生成する現象を指します。ハルシネーションのリスクについて以下に説明します。

- 1.ハルシネーションの例

- ・誤った情報の提供を行う可能性

AIが医療や法律などの専門的な分野で誤ったアドバイスや解釈を提供する場合が考えられます。例えば、「この病気にはこの治療法が有効です」とAIが言うが、実際にはその治療法は存在しない、もしくは効果が証明されていないということが起こります。 - ・架空の人物やデータの生成を行う可能性

AIが特定の人物や出来事について言及する際、架空の事実や存在しない人物を作り出すことがあります。例えば、実在しない著名な科学者や発明を紹介する場合です。 - ・矛盾する情報の提供を行う可能性

AIが提供する情報が自己矛盾を含んだり、一貫性を欠いたりすることがあります。例えば、同じ質問に対してAIが異なる、または矛盾した答えを出す場合です。

- ・誤った情報の提供を行う可能性

- 2.ハルシネーションの原因

AIのハルシネーションが発生する原因にはいくつかの要素があります。- ・データの不完全性

AIは、訓練データに基づいて予測や生成を行いますが、データセット自体に偏りや欠陥があると、その影響が出ます。訓練データに含まれていない情報や矛盾した情報が、AIの出力に反映されることがあります。

生成の仕組み:特に生成型AI(例えば、GPTなど)は、単語やフレーズを確率的に予測して次に生成します。このため、推測に基づいて「創作的な」答えを出すことがあり、事実を正確に反映しないことがあります。 - ・推論の誤り

AIモデルは、多くの場合、意味的な理解に基づいて推論を行いますが、しばしばその推論が間違っている場合があります。例えば、AIが特定の文脈や背景を理解せずに無理に結論を出すことで誤った情報を生成することがあります。

- ・データの不完全性

- 3.ハルシネーションがもたらすリスク

- ・信頼性の低下

AIが誤った情報を提供することで、ユーザーはAIに対して信頼を失う可能性があります。特に、医療や法律など、正確さが非常に重要な分野でハルシネーションが発生すると、致命的な影響を及ぼす可能性があります。 - ・社会的な影響

誤った情報が広まることで、社会全体に誤解を招いたり、偏見や誤った認識を助長することがあります。特に、ニュースやSNSでAIが生成した虚偽の情報が拡散されると、社会的に深刻な問題を引き起こすことがあります。 - ・法的リスク

AIが不正確な情報を提供した場合、法的責任が問われる可能性があります。例えば、AIが提供した医療アドバイスに基づいて健康被害が発生した場合、誤ったアドバイスを行ったAIの開発者や提供者が責任を問われるなどの可能性が考えられます。

- ・信頼性の低下

偽情報、誤情報を鵜呑みにすること(人間中心、教育・リテラシー)

AIが生成する情報には、意図しない誤りや虚偽の内容が含まれることがあり、これが誤解や混乱を生む原因となります。以下に、AIが生み出す偽情報や誤情報のリスクについて説明します。

- 1.偽情報と誤情報の違い

偽情報(Fake Information):意図的に作られた虚偽の情報で、特定の目的や利益のために広められるものです。例えば、政治的目的や経済的利益を得るために虚偽のニュースやデータを作り出すことです。

誤情報(Misinformation):事実に基づかない、もしくは間違った情報が無意識に広められることです。AIによる誤解釈やデータの誤りが原因で発生します。

AIは、自然言語生成(NLG)や生成的敵対ネットワーク(GAN)などの技術を利用して、事実と異なる情報を自動的に生成することができます。これは、特にニュース、広告、教育など、重要な場面で問題を引き起こすリスクがあります。 - 2.AIによる偽情報・誤情報のリスク

- ・社会的影響

AIが生成する偽情報や誤情報は、社会全体に広まり、偏見や誤解を助長する可能性があります。特に、以下のような社会的な影響があります。- (1)選挙や政治の影響

AIを使って政治的な目的で虚偽の情報を生成し、選挙に影響を与えることがあります。例えば、選挙候補者に関する誤った情報やディスインフォメーション(意図的な虚偽情報)が広まることで、有権者が誤った判断を下すリスクがあります。 - (2)公共の誤解を招く

AIが誤った健康情報や科学的データを生成することで、社会全体で誤解が生じることがあります。例えば、誤った医療アドバイスやワクチンに関する偽情報が広まることにより、公共の健康に悪影響を与える可能性があります。

- (1)選挙や政治の影響

- ・ビジネスと経済への影響

AIが誤情報を生成することは、企業や消費者にも深刻な影響を与えます。- (1)ブランドの信頼性の低下

AIが不正確な製品レビューや企業に関する誤情報を生成することによって、ブランドイメージが傷つく可能性があります。例えば、製品に関する虚偽の評価や広告が拡散されることで、消費者が誤って購入してしまうことがあります。 - (2)市場の混乱

金融市場において、AIが誤った経済データや株式情報を生成することで、投資家が誤った判断をするリスクがあります。このような誤情報は、株価の急落や市場の不安を引き起こす可能性があります。

- (1)ブランドの信頼性の低下

- ・個人への影響

AIが生成する偽情報や誤情報は、個人にとっても重大な影響を及ぼす可能性があります。- (1)詐欺や詐欺行為

AIを利用して虚偽の情報を広め、消費者や個人を欺く詐欺が行われることがあります。例えば、偽のオンラインストアや製品レビューを生成することによって、消費者が不正な製品を購入したり、個人情報(個人データ)が盗まれたりするリスクがあります。 - (2)個人の誤解を招く情報

AIが不正確なアドバイスや誤解を招く情報を提供することで、個人の判断が誤った方向に導かれることがあります。例えば、ダイエットや健康に関する誤ったアドバイスをAIが提供することが考えられます。

- (1)詐欺や詐欺行為

- ・社会的影響

- 3.AIが生み出す偽情報・誤情報の原因

AIによって生み出される偽情報や誤情報の原因として、いくつかの要素が挙げられます。- ・データの偏りや不完全性

AIは、大量のデータを元に学習しますが、そのデータが偏っている場合や不完全な場合、AIが生成する情報も不正確になることがあります。例えば、AIが学習したデータに誤った情報や不正確な事実が含まれていると、その結果、AIが生成するコンテンツにも誤りが生じることがあります。 - ・生成モデルの誤解

AIが情報を生成する際、言語や文脈を理解する能力が限られている場合、誤解が生じることがあります。例えば、AIが文脈を誤って解釈し、不正確な情報を生成することがあります。生成型AI(GPTなど)は、単に最も確からしい次の単語を予測するため、文脈に合わない誤った回答をすることがあります。 - ・意図的な悪用

悪意を持つ個人や団体が、AIを使って意図的に偽情報や誤情報を作成し、広めることがあります。特にディープフェイクや自動化されたソーシャルメディアアカウントなどを使った虚偽のコンテンツの拡散が行われることがあります。

- ・データの偏りや不完全性

著作権(知的財産権)との関係(安全性)

AIが生成したコンテンツや、AIを利用した開発プロセスにおいて、知的財産権が侵害されるリスクが高まる可能性があります。これらのリスクは、法的なトラブルや経済的損失をもたらすだけでなく、企業のブランドや信頼性に大きな影響を与えることがあります。以下に、AI利用における知的財産権侵害のリスクについて説明します。

- 1.AIが生成したコンテンツと著作権

AIは、文章、音楽、画像、動画などのコンテンツを生成する能力を持っていますが、これに関して著作権侵害のリスクが生じることがあります。- ・著作権者不明

AIが生成したコンテンツに関して、著作権が誰に帰属するのかが不明確です。例えば、AIが自動で生成した音楽やアートワークが著作権を有する場合、AIの開発者、ユーザー、あるいはAIそのものが著作権者と見なされるべきかどうかが法的に問題となります。日本での著作権法では、著作権は「著作者(人間)」に帰属することが原則であり、AIに自動的に著作権を与えることができるかは未解決の問題です。 - ・既存コンテンツの無断使用

AIが学習するために使用されるデータセットには、既存の著作権で保護されたコンテンツが含まれることがあります。AIがこれらのデータを無断で学習し、それに基づいて生成されたコンテンツが元の著作権を侵害している可能性があります。例えば、AIが生成した文章や画像が、他者の著作物を不正に模倣している場合、著作権侵害と見なされることがあります。

- ・著作権者不明

- 2.AIによる商標権侵害

商標は、商品やサービスを識別するために使用される標識ですが、AIによって生成されたブランド名、ロゴ、商品デザインなどが既存の商標を侵害するリスクがあります。- ・類似商標の生成

AIがブランド名やロゴを生成する場合、その出力が既存の商標に似ている、または混同を引き起こすような場合があります。商標権は、商標が他社の商標と混同されることを防ぐために存在しているため、AIによる生成物が商標侵害を引き起こすリスクがあります。 - ・商標の無断使用

AIを使用してマーケティングや広告コンテンツを作成する場合、商標を無断で使用することによって商標権を侵害するリスクもあります。特に、AIが生成したコンテンツが企業や他者の商標やロゴを無断で使用する場合、商標権を侵害する可能性があります。

- ・類似商標の生成

- 3.特許権の侵害

AIを利用して新しい技術を開発する場合、特許権の侵害が発生する可能性があります。- ・既存技術の特許侵害

AIが自動的に新しい技術やプロセスを発明する場合、その発明が既存の特許を侵害しているかどうかを確認することが重要です。AIによる発明が既存の特許技術と重なる場合、特許権を侵害することになります。 - ・特許の無断利用

AIが学習する際に、特許で保護された技術を無断で利用することによって、特許権侵害が生じる可能性があります。特に、AIモデルが特許技術を活用して生成されるプロダクトやプロセスが特許権を侵害することがあります。

- ・既存技術の特許侵害

- 4.AI開発者とユーザーの責任

AIの開発者とそのユーザーは、AIを使用する際に知的財産権を侵害するリスクを避けるための適切な措置を講じる必要があります。以下の点がリスクを管理するために重要です。- ・データセットの使用権

AIが使用するトレーニングデータが合法的に取得されたものであるかを確認する必要があります。著作権で保護されたコンテンツを許可なしに使用した場合、知的財産権侵害が発生する可能性があります。 - ・ライセンス契約の確認

AI開発者やユーザーは、使用しているソフトウェアやツール、データセットに関するライセンス契約を遵守する必要があります。例えば、オープンソースソフトウェアを利用する場合、その利用規約に従わないと、ライセンス違反や知的財産権侵害が生じることがあります。

- ・データセットの使用権

資格等との関係(安全性)

業務を行うにあたって特定の資格や免許が必要とされる分野(医療、法律、金融、建設など)では、AIによる業務遂行が法的に問題を引き起こす可能性があります。 以下に、AI活用における業法免許や資格等の侵害リスクについて説明します。

- 1.資格を持たないAIによる業務の実施

AIは、特定の資格や免許が必要な業務を担うことができますが、AI自体には法的な資格や免許が付与されないため、資格を持たないAIによって業務が遂行された場合、それが法的に適切かどうかが問題となります。- ・医療

例えば、AIが患者の診断や治療計画を提案する場合、医師免許を持たないAIが医療行為を行うことは、法律違反となる可能性があります。医療行為には、特定の医学的知識と判断力が求められ、これをAIが担うことが法的に認められるのかは議論の余地があります。 - ・法律

AIを利用して法律相談や契約書の作成を行う場合、弁護士や司法書士などの資格を持つ専門家が関与せずに業務を行うことが、無資格での業務遂行と見なされる可能性があります。弁護士法に基づき、弁護士の資格を持たない者が法律行為を行うことは原則として禁止されています。 - ・会計や税務

AIが税務相談や会計業務を自動化する場合、公認会計士や税理士が関与せずに業務が行われることで、無資格での業務が発生するリスクがあります。特に、税法や会計基準に従って業務を行うためには、資格を有する専門家が必要です。

- ・医療

- 2.AIによる無資格業務の不適切な実施

AIが自動的に業務を行う場合、資格を持つ専門家の監督がないと、誤った判断や不適切なアドバイスが提供されるリスクが高まります。AIは大量のデータに基づいて予測や判断を行うことが得意ですが、専門的な判断を求められる場面では、その精度に限界があります。

例えば、医療AIが誤った診断を下すことによって患者に害を及ぼしたり、AIが提供する法的助言が不正確であり、それによって依頼者が不利益を被ることがあります。

AIが自動化することで、従来は必要だった資格を有する専門家によるチェックが抜け落ち、業法や規制に反する行為が行われる可能性があります。 - 3.ライセンスの遵守の問題

特に企業がAIを活用して特定の業務を行う場合、AIを使用することで免許や資格を持つ者が責任を持っているとみなされるべき業務を無免許で行うリスクがあります。

例えば、AIが生成した診断やアドバイスに対して、最終的に責任を負うべき医師や弁護士がいない場合、業法や規制に反する可能性があります。つまり、AIに代わって業務を行ったことに対する法的責任の所在が不明確になるリスクです。 - 4.特定分野におけるAI活用の事例とリスク

- ・医療分野

AIが病気の診断や治療提案を行う場合、医師免許を持たないAIが治療に関与することは法律に違反する可能性が高いです。AIが生成した診断が誤っていた場合、医師が責任を問われることになりますが、AI自体には法的責任がないため、医師がその誤診に対して責任を負うことになる可能性があります。 - ・法律分野

AIによる法律相談や契約書作成ツールの利用が進んでいますが、弁護士法に基づいて、弁護士資格を持たない者が法律サービスを提供することは禁止されています。AIを使用して無資格で法的なアドバイスを行うことは、資格が必要な業務を無免許で行うことに該当し、法的責任を問われることになります。 - ・金融分野

AIを使った投資アドバイスやリスク管理の自動化が進んでいますが、金融商品取引法などの規制に従い、金融業務の免許を持つ者が行うべき業務を無資格でAIが実施することが問題となります。無資格のAIが誤った金融アドバイスを提供することによって、投資家が損失を被る場合、法的責任の所在が不明確になります。

- ・医療分野

バイアスの再生成(公平性)

AI活用におけるバイアスの再生成リスクは、AIシステムが学習するデータやアルゴリズムに内在する偏り(バイアス)が、AIの出力結果にも反映され、これが再現され続けるリスクを指します。バイアスの再生成は、AIシステムが人間社会の多様性を適切に反映できない結果を生む可能性があり、その影響が長期的に広がることがあります。このリスクは、特に社会的、倫理的、法的な観点から問題視されています。

バイアスが再生成されるプロセスは、いくつかの段階で発生します。

- 1.不均衡なデータセット

AIが学習するデータには、社会的、経済的、人種的、性別的などの偏りが含まれていることがあります。ある特定のグループに偏ったデータで訓練されたAIは、そのグループに有利な結果を出す一方、他のグループに不利な結果を生む可能性があります。 - 2.歴史的バイアスの学習

AIが過去のデータを基に学習する場合、歴史的に存在した社会的な不公平や差別がAIに組み込まれる可能性があります。過去の採用データや裁判記録が男性優位の傾向を持っていると、AIはその傾向を学習し、同じような偏見を将来の判断に繰り返し適用する可能性があります。 - 3.アルゴリズムの設計やフィードバックループ

AIのアルゴリズムが特定のバイアスを持つ設計をされている場合、そのバイアスが学習中に強化され、最終的な決定に影響を与えることになります。

さらに、AIの出力がその後のデータに影響を与えると、フィードバックループが発生します。例えば、あるAIシステムが特定のグループに対して差別的な出力をすることで、そのグループが新たなデータとしてAIに入力され、それによってAIがその差別的な傾向を強化してしまうことがあります。

バイアス再生成の例には以下のようなものがあります。

- 1.採用アルゴリズムにおける性別バイアス

ある企業がAIを使用して新しい従業員を選ぶ場合、過去の採用データが男性の応募者が優遇されていた場合、AIはそのバイアスを学習し、次に女性候補者を不利に扱う可能性があります。これにより、女性候補者が不平等に扱われ、職場の多様性が損なわれる可能性があります。 - 2.司法判断における人種バイアス

AIが過去の裁判データを基に判決予測を行う場合、過去の裁判における人種差別的な判断がAIに学習され、これを基に不公平な予測を行うことがあります。例えば、AIが黒人被告に対して不当に高い判決を予測する場合があります。 - 3.健康診断における医療バイアス

AIを使用した健康診断システムが、過去の患者データに基づいて疾患のリスクを予測する場合、ある人種や性別に偏ったデータで学習していた場合、特定のグループに対する誤診や不正確なリスク評価を行う可能性があります。特に、特定のグループに対して適切な診断が行われないと、健康問題が見逃されるリスクが高まります。

ディープフェイクという脅威

AI利活用において多種多様のリスクがある中で、今後特に気をつけるべきリスクとして「偽情報(ディープフェイク)」があるかと思います。なぜならばこのディープフェイクを起点として様々な情報操作、サイバー攻撃、政治・軍事利用等の脅威の派生が可能になり、その精度は人の五感で見破ることが不可能なレベルになりつつあることもあります。

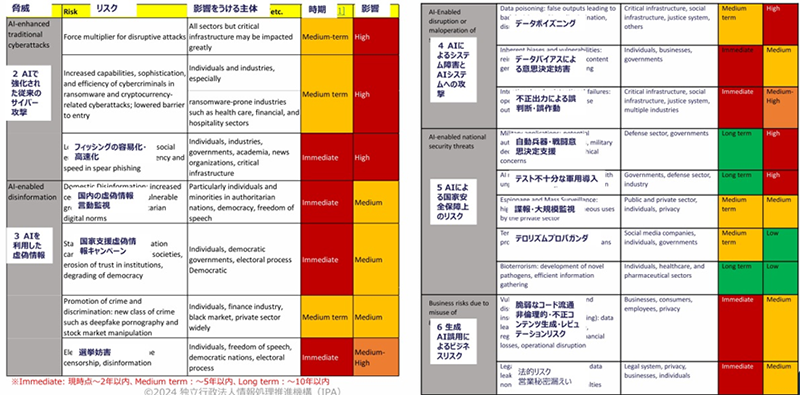

IPAの「米国におけるAIのセキュリティ脅威・リスクの認知調査レポート(概要)」[4]では、すでにディープフェイクを利用した諸々のリスクはすでに顕在化しており、多方面で影響を与える可能性が指摘されています。

表2:米国脅威調査のまとめ:類型別のインパクト[4]

例えば米国大統領選挙におけるAIを利用したディープフェイクコンテンツの流通は既に「当たり前」の状況になっており、直接的な選挙妨害の他にも、間接的な社会分断を誘導させるような脅威、リスクも出始めている状況にあります。このようなリスクが具体的にどのようなものなのか簡単に紹介します。

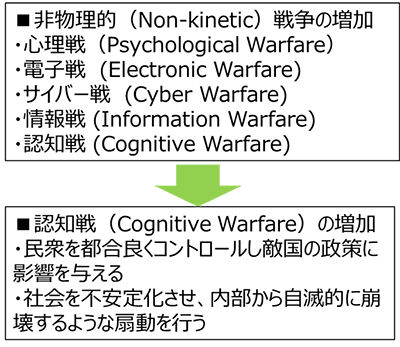

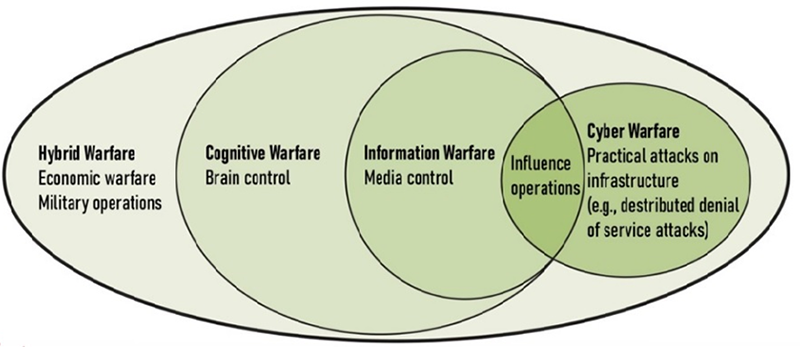

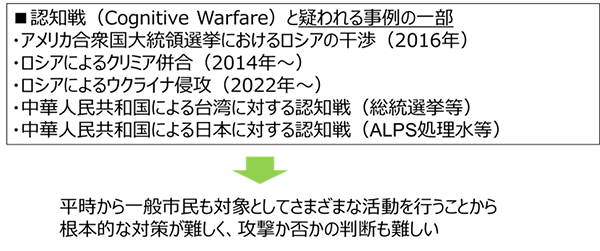

認知戦(Cognitive Warfare)とは何か?

民衆を都合良くコントロールし敵国の政策に影響を与えたり、社会を不安定化させ、内部から自滅的に崩壊するような扇動を行ったりする行為を認知戦(Cognitive Warfare)と呼びます。[5]

認知戦の特徴として、人の脳における認知領域を標的として攻撃を行う戦争の形態を指し、脳特有の脆弱性を利用して人の精神や行動をコントロールすることを目的とします。

認知領域は陸、海、空、宇宙、サイバー空間に次ぐ「第6の戦場」として捉えられており、各国が攻防を研究している状況にあります。

「認知戦(Cognitive Warfare)の考え方」[5]

従来の戦争(物理的暴力、破壊、領土征服等)とは異なり、認知戦は思想、感情、知覚の領域で活動し、人間の心の脆弱性を利用しようとするものになります。

その考え方は孫子における「戦わずして勝つ(超訳)」といった兵法に通じるものがあり、現代では進化したAIの登場によってより洗練された攻撃手法となり、人間の心の脆弱性をたくみに利用しようとする戦い方になります。

図1:認知戦の概念と関係性[6]

では具体的に認知戦の事例にはどのようなものがあるのでしょうか?

どのような証拠をもって認知戦を証明することは実際には難しく、あくまで推測でしか判断できないのが現実のようです。

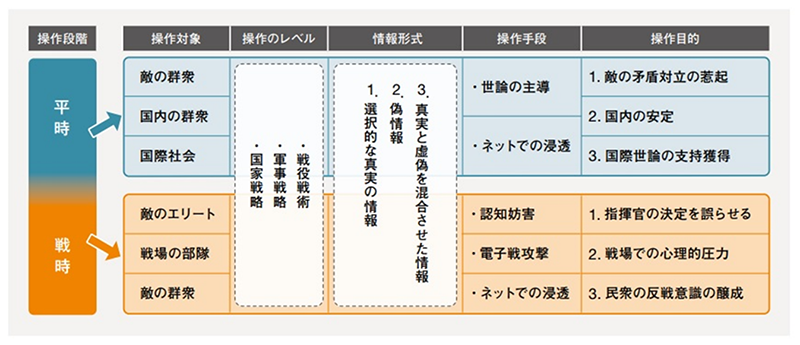

また、認知戦では平時(戦争をしていない段階)と戦時(戦争中の段階)で手法を変えてくる場合もあり、平時では間接的な攻撃(大衆先導等)が中心となり、戦時ではより直接的な攻撃(サイバー攻撃等)を仕掛けてくる場合もあるようです。

図2:平時および戦時での認知戦例[7]

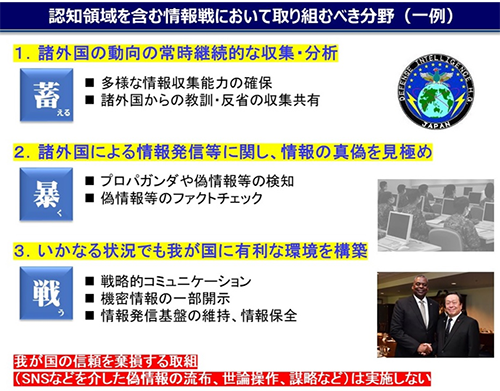

このような認知戦を仕掛けられた場合、どのような対策が必要なのでしょうか?

当然のことながら国防に関わる組織ではこのような脅威分析を行っており、さまざまな対策を現在進行形で整備をしている段階かと思われます。

一般市民の立場からすると、SNS等で流れてくる情報をそのまま鵜呑みにすることなく、ファクトチェックを常に行うことが理想ではありますがなかなか難しい問題かと思います。例えば事実が6割、ディープフェイクが4割といったように事実ベースの事象にディープフェイクを混ぜ合わせた情報を大量に拡散された場合、ファクトチェック自体がより難しくなり、誤情報のまま事実だと認識されてしまうリスクがあります。ディープフェイクは比較的簡単に作成できますが、ファクトチェックは多様な分析が必要になるため労力がかかります。

図3:認知領域を含む情報戦において取り組むべき分野(一例)[8]

一般組織におけるAIリスクコントロールのやり方

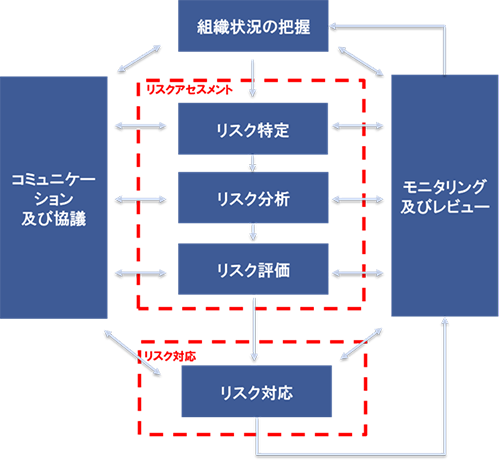

一般組織においてのAIリスクコントロールをどうすべきかを考えてみます。

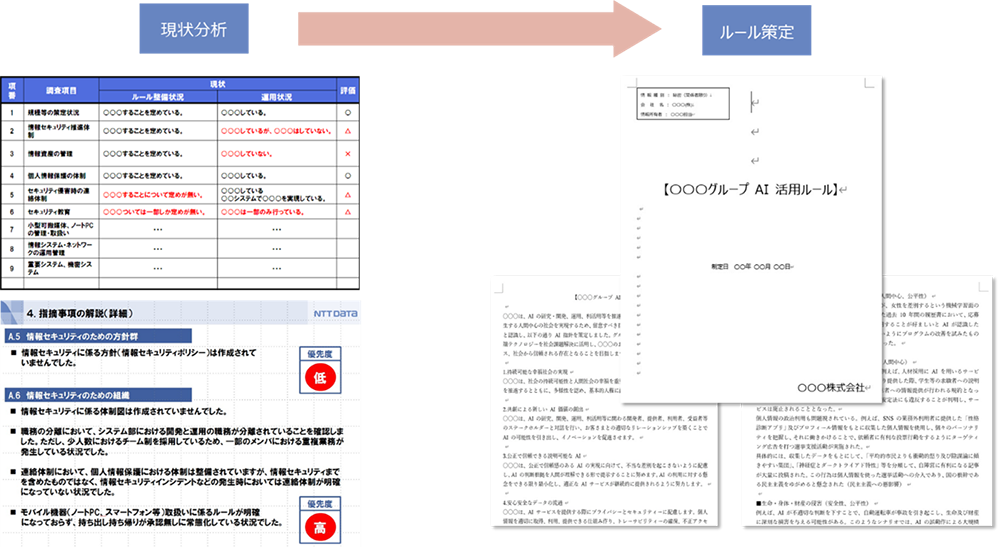

AIをどのような形で利活用するのかによってリスクも異なるため、まずは現状分析などでAI開発・提供・利用状況(予定)を把握し、業種業態に合わせたリスクアセスメント、リスク対応などのリスクベースアプローチが有効かと思います。

図4:リスクベースアプローチの考え方(一例)[9]

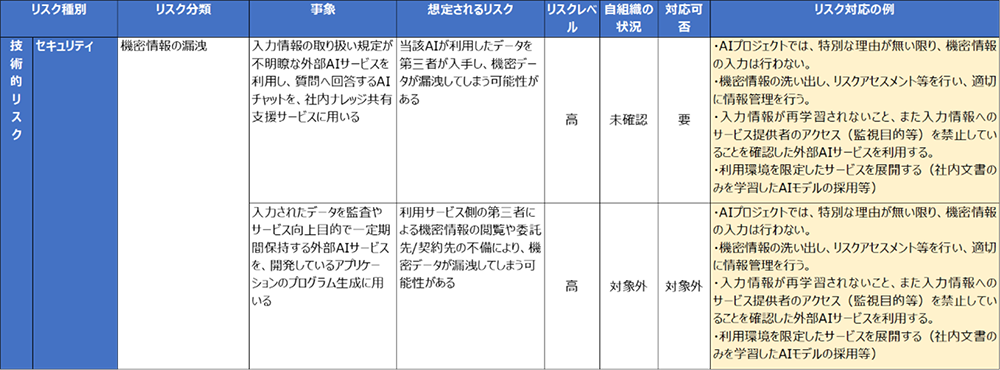

表3:リスクベースアプローチによるリスク対応(一例)

リスク対応までのプロセスに目途がついたならば、継続して運用を行っていくためのルール化、文書化、教育、定期的なチェック(監査等)の仕組みを整備すると良いかと思います。

図5:現状分析からリスクベースアプローチによるルール策定(一例)

AIの進化のスピードは非常に速いため、日常的に情報収集を行い、一度作成したルールでも状況によっては柔軟に変えていく必要があります。定期的なリスクベースアプローチによる見直しをかけるとよいでしょう。

AIの使い方が多様になるほどリスクも表裏一体に出てきそうね。

今後は他国も含めた法整備の動向や業界ごとのガイドラインなんかも気配る必要がありそうやで。

AI ゲーム 荒稼ぎ……

次回はAI活用における倫理について説明する予定です。

参考文献

- [1]総務省、経済産業省(2024):「AI事業者ガイドライン(第1.01版)」

- [2]総務省、経済産業省(2024):「AI事業者ガイドライン(第1.0版)別添(付属資料)概要」

- [3]総務省、経済産業省(2024):「AI事業者ガイドライン(第1.01版)別添(付属資料)」

- [4]IPA(2024):「米国におけるAIのセキュリティ脅威・リスクの認知調査レポート(概要)」

- [5]NATO Innovation Hub (2023):「The Cognitive Warfare Concept」

- [6]University of Ottawa, DANIEL NIKOULA, DAVE MCMAHON (2024):「Cognitive Warfare: Securing Hearts and Minds」

- [7]防衛研究所 (2023):「中国安全保障レポート 2023-認知領域とグレーゾーン事態の掌握を目指す中国-」

- [8]防衛省・自衛隊:「認知領域を含む情報戦への対応」

- [9]ISO/IEC:「IEC31010:2019 Risk management - Risk assessment techniques」

- ※文中の商品名、会社名、団体名は、一般に各社の商標または登録商標です。