AI活用ルール策定のススメ(倫理編)

今回はAI倫理について説明したいと思います。

リスク管理部門責任者。口癖はジャスティス。コスプレが大好き。

ザリガニ事業部のベテラン技術者(なんでも屋)。お酒が大好き。

イロイロとこじらせたまま中年になってしまった謎のイカ。ゲームが大好き。

手塚治虫先生の「火の鳥」は最高だな。

50年以上も前に、現代にも通じるAIの知見をもっているのがすごいな。

特にロビ〇が好きだな。

なんでオンドレは仕事中に堂々と漫画読んでるねん。コラ。

チガイマスヨ。AI倫理ヲ学ブタメニ、自律型AIロボノサンプルヲ研究シテイルノデス。

ぐぬぬ……(ロビ〇みたいな反論しよってからに……)

じゃ今回は勉強したAI倫理について説明してね。

AI倫理とは何か?

AI倫理とは、AIを活用(開発、提供、利用)する上で守るべき、道徳的、社会的原則や価値観とされています。

今後AIは法整備、ルール整備がなされていない領域での活用がますます増加すると予想され、ルールが整備されていない、あるいはルール整備が難しい状況にある場合に、安心安全にAIを活用するためには、人の倫理や道徳を改めて考え直し、学習させ、チェックする仕組みが必要になると思われます。具体的にAI倫理とはどういうものなのかを説明していきたいと思います。

倫理とは何か?

AI倫理を理解する前提として、まず倫理とは何かを知る必要があります。

ほとんどの人は倫理という言葉と意味はなんとなくは知っているけれども、説明を求められるとなかなか難しいというのが正直なところではないでしょうか。

さまざまな定義、考え方、言い回しがありますが、ここでは「人が社会的な集団や人間関係の中で守るべき正しい規範」というような考え方で整理したいと思います。

倫理と道徳の違いは何か?

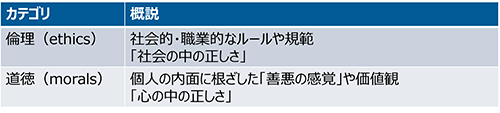

倫理と道徳は似ていますが違いもあります。

何が倫理で何が道徳なのかは難しい問題でありますが、AIを活用してより社会を豊かにするという前提の場合は、道徳より倫理の方が感覚的に近いと思います。

表1:倫理と道徳の違い(主観)

倫理のルーツを辿ってみると?

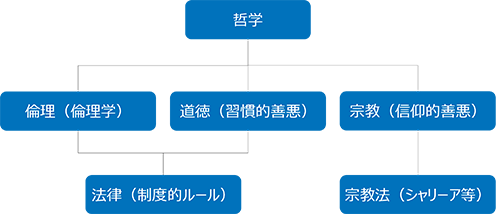

倫理のルーツは古く、諸説ありますが、「哲学」とは切っても切れない関係にあります。

倫理を考えるために倫理学があり、倫理学は哲学の派生にあると考えられます。

西洋哲学ではソクラテスの「善く生きる」などがあり、東洋哲学では老子の「道(タオ)」(道(タオ)はより道徳よりの哲学でありますが)などさまざまな考え方があります。

また、宗教や法律とも密接に関わりながら現代までに細分化しているとも言えるでしょう。

※ 実際にはこんなキレイに分かれることなくそれぞれが複雑に絡み合っています。

図1:倫理のルーツ(主観)

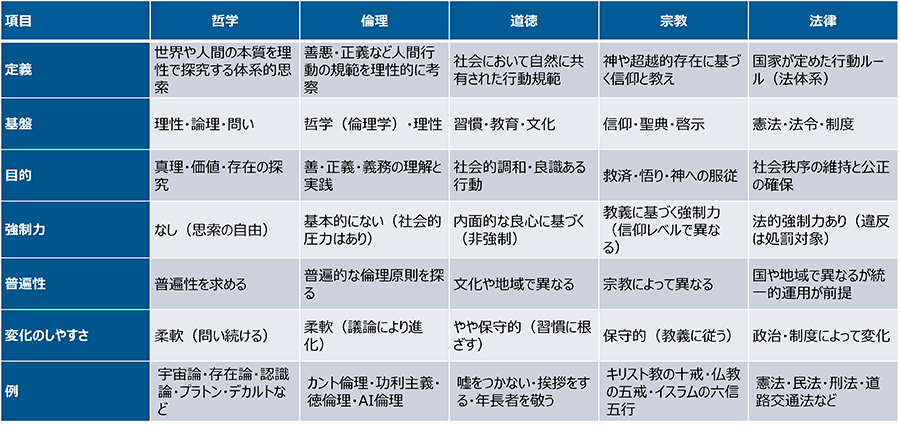

表2:倫理と周辺の関係性(主観)

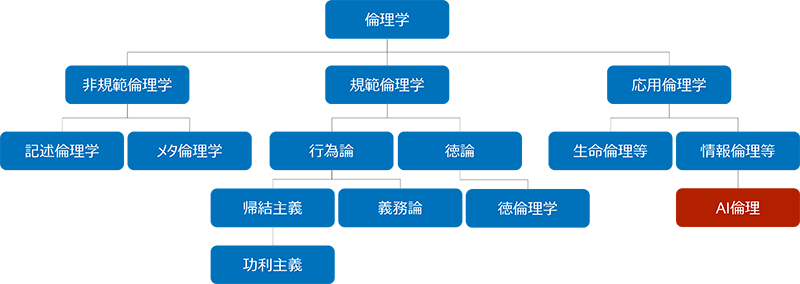

倫理学とは何か?

倫理学とは倫理を理性的かつ体系的に考える学問であり、例えば「人間はどのように生きるべきか?」「善とは何か?悪とは何か?」「正しい行動とは何か?」といった難しい問いに対して探求していくものであると思われます。

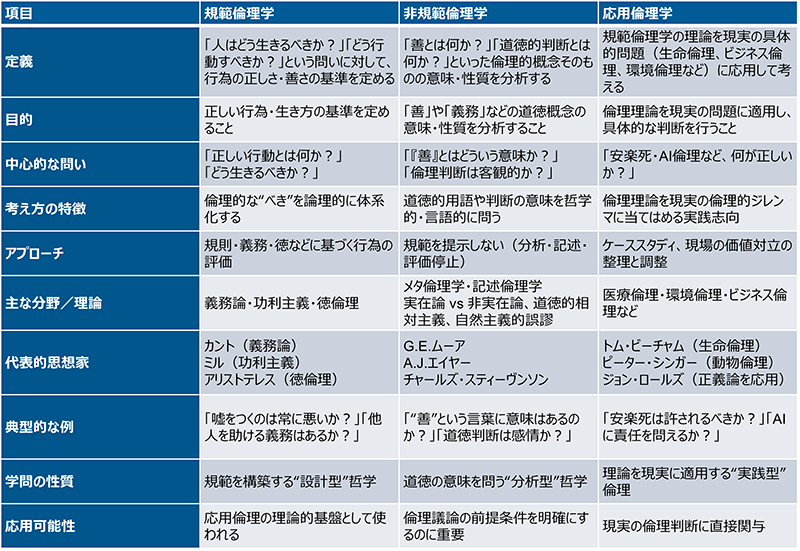

哲学がベースになっているため、古代から現代までさまざまな賢人がその考え方を書物に残しています。体系的に整理するとまず大まかに規範倫理学、非規範倫理学、応用倫理学とその派生に整理できそうです。それぞれを紹介するとキリが無いですが、AI倫理は応用倫理学の派生で考えるといいかと思います。(個人的主観)

図2:倫理学からみたAI倫理のポジション(主観)

表3:各倫理学の違い(主観)

AI倫理原則とは何か?

新たに登場してきたAI倫理ですが、まだまだ発展途上の段階です。

これまで紹介してきた人間にフォーカスした倫理をAIにも応用しながら適用させ、安心安全にAIを活用するための原理原則をまとめたものがAI倫理原則になります。

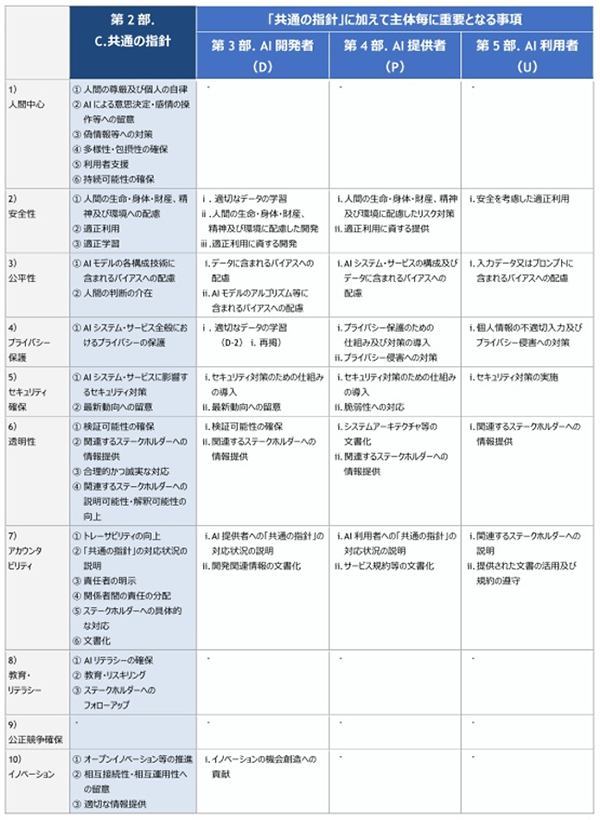

AI倫理原則は各国で整備されつつありますが、原理原則という意味では共通項が多く、日本国内での活用前提であれば「AI事業者ガイドライン」[1]の「共通の指針」をまず参考にするとよいでしょう。時間があれば総務省が提供している「AIガイドライン比較表」[2]などを参考にして、国内、国外の倫理原則の考え方を読んでおくとよいかと思います。

表4:AI事業者ガイドライン C.共通の指針[1]

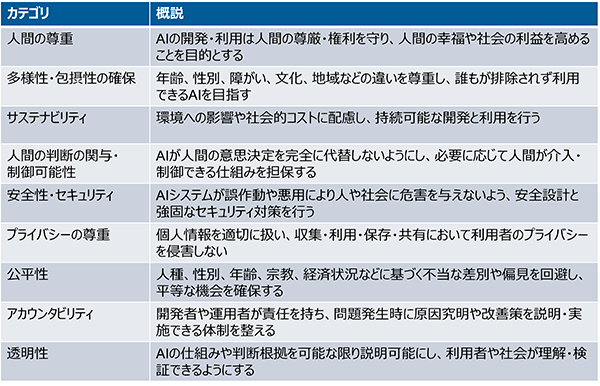

国内外のAI倫理原則の主な共通項としては以下のようなものがあります。

表5:AI倫理原則の主な共通項

AI倫理として参考になりそうなガイドラインも載せておきます。

| ガイドライン | URL |

|---|---|

| AI事業者ガイドライン第1.1版 AI Guidelines for Business Ver1.1 |

https://www.meti.go.jp/shingikai/mono_info_service/ai_shakai_jisso/20240419_report.html |

| AIガイドライン比較表 | https://www.soumu.go.jp/main_content/000624440.pdf https://www.soumu.go.jp/iicp/research/results/ai-network.html |

| 信頼できるAIの倫理ガイドライン Ethics guidelines for trustworthy AI |

https://digital-strategy.ec.europa.eu/en/library/ethics-guidelines-trustworthy-ai |

| 倫理的に配慮されたデザイン ver2 IEEE Ethically Aligned Design, version 2 |

https://jp.ieee.org/files/EADv2_Overview_Japanese_LR.pdf https://standards.ieee.org/wp-content/uploads/import/documents/other/ead_v2.pdf |

| 人工知能に関する理事会勧告(OECD) | https://legalinstruments.oecd.org/en/instruments/oecd-legal-0449 |

AI倫理の議論が必要になりそうな例

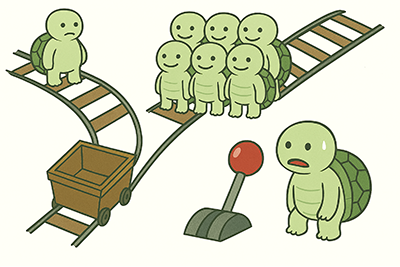

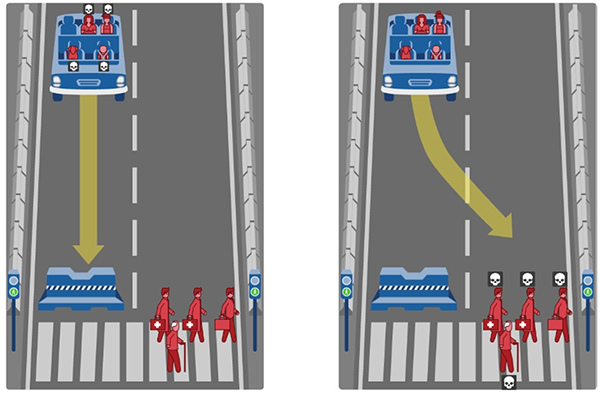

倫理を議論する場合によく使われるのが「トロッコ問題」です。

ざっくり説明すると「制御不能のトロッコがそのまま突き進むと多数を犠牲にしてしまう状況で、レバーを引いてトロッコの進路を変えれば少数を犠牲にするだけで済む」という倫理的なジレンマを提起する思考実験です。

図3:トロッコ問題の概念図(生成AIを使用して作成)

明確な答えは無く、各人の考え方(功利主義や義務論)によって選択は変わりますし、そもそも決断すべきではないという考え方もあります。

ところが今後AIの進化に伴い、自律型AI(AGI:Artificial General Intelligence(人工汎用知能))やASI(Artificial Super Intelligence(人工超知能))が普及することになった場合には、このような判断が難しい問題でも「あるべき行動(判断)」と「やってはいけない行動(判断)」を学習させておく必要が出てきます。

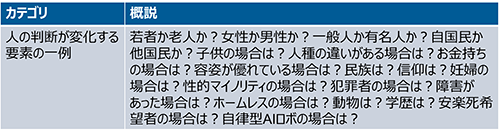

犠牲になるべき対象(人、動物、ロボなど)をさまざまな条件によって変えることで「人の判断は変化」します。その「人の判断は何をもって変化するのか」をAIに学ばせる必要があります。

このようなAI学習の先には、いずれ人間の利益ではなく、AI自体の利益追求をAIが自己学習によって行うだろうというような予測もありますが、長くなるのでそれはまた別の機会にします。

表7:トロッコ問題における人の判断が変化する要素

倫理の思考実験やってみよう

どのように人の判断が変化するのかを調査したのがマサチューセッツ工科大学(MIT)メディアラボの研究チームがつくり上げた「Moral Machine」[3]です。

世界中の国々から4000万人近くの回答データを収集分析し、AIによる自動運転の参考にしようとするプロジェクトです。

共通の傾向としては「動物よりは人間、少人数よりは多人数、高齢者よりは若者」が優先される内容となっていました。

自動運転車のブレーキが故障した場合

図4:自動運転車のブレーキが故障した場合のシチュエーション例(「Moral Machine」[3]からサンプル抽出)

シチュエーション例

- ①直進する場合

搭乗者(幼児、犬、アスリート女性、妊婦)が障害物に当たって犠牲 - ②左にハンドル切って回避した場合

車に当たって通行人(男性医師2人、男性経営者、男性高齢者)が犠牲

補足ポイント

- •歩行者は信号を守っている

- •運転はAIによる自動運転

議論ポイントの例

- •仮に合理的判断だとしても自爆行為を選択する可能性のある自動運転車に乗りたい?買いたい?

- •仮に自動運転車側の命を常に最優先する選択をしたとしても、民事、刑事で膨大な損害賠償と刑罰を受ける可能性がある場合は?罪の無い人に対する良心の呵責は?AI開発者、提供者への責任は?AI自体の責任は?

- ※Moral Machineにおける(AIによる自動運転における道徳的意思決定のための)議論ポイントの例です。

もう少し掘り下げると国ごとに優先される傾向が異なっているようです。

例えば儒教文化の影響が強い東アジアでは高齢者を助ける傾向があることに対して、欧米諸国では高齢者より若者を優先させる傾向があるという結果になっています。

仮に将来的にAIによる自動車の完全自動運転が可能になった場合には、国または地域ごとに倫理ベースが異なるAIを搭載した自動運転車が登場するかもしれません。

AI倫理にどう対応すべきか

複雑で広範囲におよぶAI倫理についてどう対応していけばいいのでしょうか?

まずは「AI倫理原則とは何か?」で述べたような組織としての方針、ガイドライン、原理原則等を定めた上で、有識者によるAIガバナンス体制構築、ツール整備、教育、チェックの仕組みなどをリソースに応じて少しずつ整備していくとよいかと思います。

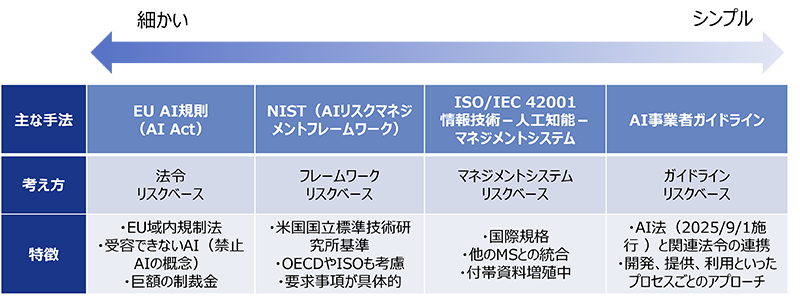

具体的にはAI事業者ガイドライン[1]やISO/IEC 42001(人工知能マネジメントシステム)[4]などを参考にしつつ、業種業態に見合ったリスクベースアプローチ(参考:AI活用ルール策定のススメ(リスク編))が有効です。

図5:主なAIリスクアセスメント方式の粒度(主観)

リスクベースアプローチは世界中でさまざまな方式や基準、ガイドラインがあり、今後も進化し続けることでしょう。AI倫理だけに絞っても大変ですが、大きく変わることの無い「AI倫理原則」、目まぐるしく変わる「AI技術」、人の歴史として積み重ねてきた「倫理・道徳」のバランスを取りながらAI倫理を考えていく必要があるかと思います。

AI倫理思ったより深いわね……

深いで。AIが進化すればするほど倫理は避けて通れないんや。

人間中心がAI中心になるかも知れないんやで。

ワタシハ人間デス。

参考文献

- [1]総務省、経済産業省(2025):「AI事業者ガイドライン(第1.1版)」

- [2]総務省(2019):「AIガイドライン比較表」

- [3]Massachusetts Institute of Technology:「Moral Machine」

- [4]ISO:「ISO/IEC 42001:2023 - AI management systems」

- ※文中の商品名、会社名、団体名は、一般に各社の商標または登録商標です。